IAs, pour des Intelligences Alien(ée)s / AIs, for Alien(ated) Intelligences

Les débats qui agitent la sphère médiatique à propos de l’IA, en particulier depuis le succès public de chatGPT, imposent souvent des coordonnées du problème dont les présuppositions deviennent aussi opaques qu’elles gagnent en influence, faisant du raisonnement un symptôme qu’on peut tout au plus décrypter. Le plus souvent, on critique ou on surestime l’IA en lui accordant une fantasmatique autonomie matérielle et cognitive.

On peut présenter la controverse comme suit : certains estiment que l’IA va nous permettre d’augmenter notre intelligence, tandis que d’autres pensent que c’est tout le contraire. La première position est libérale et tente de maximiser un gain. Elle conçoit l’intelligence comme quelque chose qu’on peut quantitativement augmenter ou diminuer et pour laquelle il y a donc une échelle de valeur commune et objective. L’IA permettrait de gagner en productivité, en rapidité et en capacité, et serait donc un merveilleux outil. La seconde position consiste à croire que l’IA, en normalisant et en simplifiant par la quantification, les processus cognitifs, va aussi normaliser et simplifier, jusqu’à disparition. L’intelligence humaine est une forteresse assiégée par les forces du calcul et de l’argent, de tout ce qui quantifie et réduit l’être humain à sa mesure en occultant le « supplément d’âme ». Le crime serait sans témoin car si l’intelligence humaine disparaît, alors la possibilité de signaler le crime disparaît aussi. Cette seconde position est souvent de « gauche » et défend l’existant, tandis que la première est de « droite » et rentabiliste.

Ces deux positions partagent un angle mort : elles présupposent qu’elles savent déjà ce qu’est l’intelligence (humaine), ce qu’il faut préserver ou augmenter. Si on critique ou si on adule l’IA, c’est le plus souvent en supposant que l’on sait à la manière d’une évidence, ce qu’est l’intelligence, car on se la donne à soi-même. L’intelligence en s’observant se trouve très intelligente et évalue toute chose à sa mesure. Le retournement de cette faculté sur elle-même au moment où elle prétend évaluer la situation de l’IA est rarement problématisé dans ces controverses.

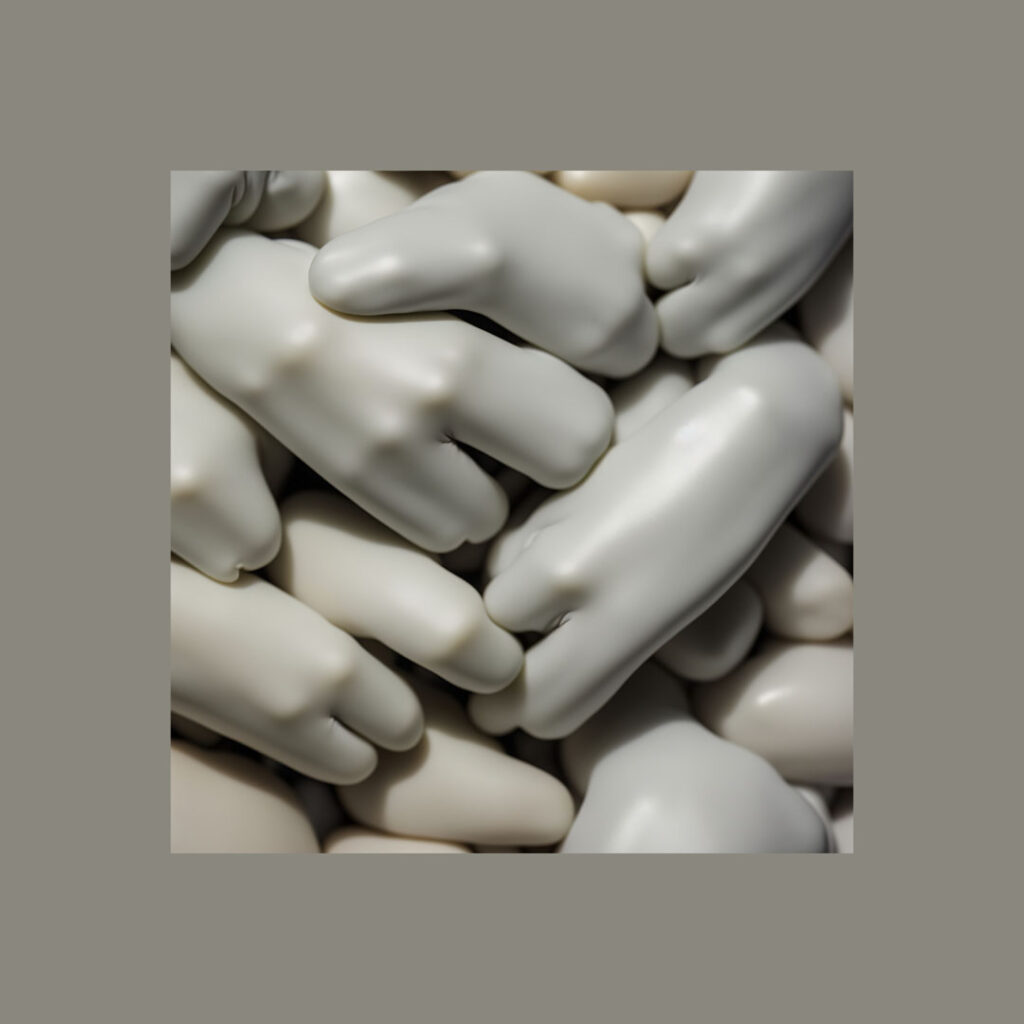

J’aimerais ici proposer une troisième situation qui, loin de rentrer dans la dialectique de cette controverse, tente d’en déconstruire les présupposés sans pour autant les surplomber, mais en les jouant et en les rejouant d’une manière différente : les intelligences aliénées. Car ce qui est en jeu avec l’IA c’est soit une préconception de celle-ci à l’aune de laquelle on juge et on évalue les résultats, restant au niveau d’une instrumentalité qui estime que c’est l’esprit qui oriente la matière formée qu’on nomme technique, soit une expérimentation qui tente de voir ce qu’on peut faire à l’IA et ce que l’IA nous fait. Il me semble que cette manière de procéder répond et participe à ce que Turing, et plus largement la première cybernétique, avaient formulé dans les années 50. Par cette position, on ne suppose pas qu’on sait ce qu’est l’intelligence (humaine) et si même il y a de l’intelligence, si sa présence est du mode de la propriété (« mon intelligence »), qu’elle consiste en elle-même, dans son autonomie, ou si elle n’est que l’expression, à la manière d’un reflet ondoyant, d’un autre processus. On estimera qu’il n’y a d’intelligence qu’au sens d’une « bonne intelligence », c’est-à-dire d’un agencement, d’un arrangement, d’une mise en relation et que, pour le dire autrement, l’intelligence est le produit d’une relation (souvent d’appropriation et d’identification) plutôt que l’inverse. On reconnaît alors que les technologies sont performatives et qu’elles ne répondent pas simplement au monde tel qu’il existe, mais produit et sont le produit du monde en train de se faire.

Ces intelligences sont aliénées, c’est-à-dire qu’elles deviennent autres, elles se transforment, se métamorphosent et ne sont que ce « change » (Malabou). L’intelligence n’est pas quelque chose qui existerait en soi, l’intelligence n’est que son « change » par laquelle elle devient autre qu’elle-même s’aliène. Elle peut faire de cette aliénation le motif d’une terreur dont il faut se protéger pour garder son ipséité, son identité, ou alors la structure d’un désir : vouloir être autre, non pas pour se diminuer ou s’augmenter par rapport à une origine qui serait présence à soi, mais pour sentir le différentiel de cette aliénation.

La méthode de ces intelligences aliénées est l’expérimental, c’est-à-dire que pour apprendre une chose il faut faire cette chose, se faire avec cette chose, la bricoler et par là même se bricoler. L’incertitude de l’ipséité est alors pleinement assumée et affirmée, et les stratégies consistant à voir l’IA comme un plus ou un moins deviennent les scènes grotesques qui tentent de préserver le fantasme d’une intelligence considérée comme quelque chose non seulement de précieux, mais de divin.

On accorde par l’intelligence une exceptionnalité à l’être humain qui, au cours de son histoire, a consisté à attribuer cette intelligence ou à la refuser, non seulement aux non-humains, mais aussi à certains humains, racisés et colonisés. C’est cette exceptionnalité accordée à soi-même par la faculté qu’on croit désigner qu’il faut déconstruire, car elle est le privilège d’une domination qui partage le monde. Si certains veulent protéger l’intelligence humaine de l’IA, c’est qu’elle est fragile tout autant que précieuse et que si elle disparaît alors le risque est mortel puisqu’il ferait purement et simplement disparaître l’humanité : à force de diviser le monde, on pourrait bien disparaître à son tour.

Les deux premières positions dont nous avons parlé sont humanistes, réactionnaires de gauche et libérales de droite, car elles font de l’être humain l’unique échelle de valeur de toutes choses. Elles n’imaginent pas que l’IA pourrait bien être une intelligence, mais en un tout autre sens que l’intelligence humaine, une intelligence alien(ée) qui se refuserait à nous. Nous n’en serions pas le paradigme et notre « propre » ne permettrait pas d’y accéder. Malgré certaines évolutions de notre sensibilité ces dernières années, nous avons encore du mal à considérer pleinement les autres intelligences et à même défaire le privilège de cette faculté sur d’autres modes de relations. Nous continuons à scruter le monde selon une logique du semblable et du dissemblable, estimant que le premier à une dignité supérieure au second. Ce n’est pas seulement l’anthropocentrisme, c’est une manière de constituer le monde en tant que monde, de faire tenir l’en tant que tel devant soi à partir de ce précipice de la raison.

Il peut t avoir quelque joie à imaginer cette situation : des êtres humains, ayant créés un isolement divin de leur espèce en se croyant exceptionnels, produisent des machines qui s’inspirant des traces de leur espèce, génèrent d’autres types de raisonnements, de logiques, de vérités. À la fin, car l’IA est en quelque sorte la fin d’un long processus d’externalisation cognitive, on serait tout aussi seul qu’au début, mais seul en un autre sens, selon une autre qualité de solitude qu’on pourrait qualifier d’aliénation.

Alors bien sûr, celle-ci ne doit pas nous mener à valoriser de façon romantique l’aliénation mentale, car il faut distinguer, même si la limite est tremblante, entre une aliénation qui détruit la fragile réflexivité d’un individu qui l’empêche même de poser une différance, et l’aliénation qui peut être un objet de désir pour la réflexivité. Qu’est-ce que ce désir au juste ? C’est le désir, non la volonté, de se perdre pour que quelque chose d’autre que soi ait lieu : être l’occasion hasardeuse d’une autre aliénation que celle qu’on est déjà parce qu’on est un être réflexif. La réflexion comme pensée de la pensée, perception de la perception, mémoire de la mémoire, différance donc au sens derridien, machine à différer et à archiver que nous sommes.

Face aux grands récits critiques ou fascinés envers l’IA s’ouvre la possibilité d’une tout autre fiction, celle des intelligences aliénées. Par intelligence, nous ne visons pas seulement celle de l’être humain ou celle de la machine, mais la différance entre les deux, c’est-à-dire le fait que cette aliénation réciproque de l’un et de l’autre (j’influence l’IA comme elle m’influence) met en doute le « de » que je plaçais avant l’intelligence en désignant un propriétaire de celle-ci. Cette désappropriation réflexive de l’intelligence, dans l’entrebâillement de l’anthropotechnologie, n’est pas sans rapport avec le long processus historial d’externalisation de la rationalité que je nomme la rétention quartiaire, l’ajoutant aux trois premières proposées par Bernard Stiegler.

Les intelligences aliénées sont donc toujours au pluriel : si je désire être aliéné par l’IA c’est aussi parce que je désire l’aliéner, et si je ne sais pas qui je suis, je ne sais pas qui elle est. Je propose de marquer cette pluralité structurelle, puisqu’elle est le fruit de la relationnalité, dans l’acronyme IAs, un simple « s » comme manière d’introduire la différance dans l’IA. Une intelligence n’est jamais seule, non pas seulement parce qu’elle s’associerait à d’autres intelligences, mais parce qu’elles ne sont qu’ensembles. Une intelligence est toujours aliénée parce que si elle rêve de son autonomie inscrite au cœur même de sa réflexivité, elle consiste dans le partage avec d’autres (intelligences). Cette relationnalité n’est en rien une confusion océanique où il n’y aurait qu’un grand Esprit. Elle coexiste avec le déchirement entre les intelligences : nous savons bien que ce chat, qu’il soit GPT ou animal, est intelligent, mais tout en reconnaissant cette faculté, nous percevons sa solitude, notre solitude, car nous n’arriverons (peut-être) jamais à composer avec nos intelligences, nous ne pouvons qu’en faire la promesse.

–

The debates that agitate the media sphere about AI, especially since the public success of chatGPT, often impose coordinates of the problem whose presuppositions become as opaque as they gain in influence, making the reasoning a symptom that can at most be deciphered. Most often, AI is criticized or overestimated by granting it a phantasmatic material and cognitive autonomy.

The controversy can be presented as follows: some believe that AI will allow us to increase our intelligence, while others think that the opposite is true. The first position is liberal and tries to maximize a gain. It conceives intelligence as something that can be quantitatively increased or decreased and for which there is therefore a common and objective value scale. AI would allow us to gain in productivity, speed and capacity, and would therefore be a wonderful tool. The second position consists in believing that AI, by normalizing and simplifying cognitive processes through quantification, will also normalize and simplify them, until they disappear. Human intelligence is a fortress besieged by the forces of calculation and money, of everything that quantifies and reduces the human being to its measure, obscuring the “extra soul”. The crime would be without witness because if human intelligence disappears, then the possibility of reporting the crime disappears too. This second position is often “left-wing” and defend the existing, while the first is “right-wing” and profit-oriented.

These two positions share a blind spot: they presuppose that they already know what (human) intelligence is, what should be preserved or increased. If we criticize or if we praise AI, it is most often by assuming that we know, in the manner of a self-evident fact, what intelligence is, because we give it to ourselves. Intelligence, by observing itself, finds itself very intelligent and evaluates everything according to its measure. The turning of this faculty on itself at the moment when it claims to evaluate the situation of AI is rarely problematized in these controversies.

I would like to propose here a third situation which, far from entering into the dialectic of this controversy, tries to deconstruct its presuppositions without overhanging them, but by playing them and replaying them in a different way: alienated intelligences. For what is at stake with AI is either a preconception of it by the yardstick of which we judge and evaluate the results, remaining at the level of an instrumentality that considers that it is the mind that guides the formed matter that we call technique, or an experimentation that tries to see what we can do to AI and what AI does to us. It seems to me that this way of proceeding responds to and participates in what Turing, and more widely the first cybernetics, had formulated in the 50s. By this position, one does not suppose that one knows what (human) intelligence is and if there is even intelligence, if its presence is of the mode of property (“my intelligence”), that it consists in itself, in its autonomy, or if it is only the expression, in the manner of an undulating reflection, of another process. One will consider that there is intelligence only in the sense of a “good intelligence”, that is to say of an arrangement, of an arrangement, of a setting in relation and that, to say it differently, intelligence is the product of a relation (often of appropriation and identification) rather than the opposite. One recognizes then that technologies are performative and that they do not simply respond to the world as it exists, but produce and are the product of the world in the process of being made.

These intelligences are alienated, that is to say that they become other, they transform themselves, metamorphose themselves and are only this “change” (Malabou). The intelligence is not something which would exist in itself, the intelligence is only its “change” by which it becomes other that itself alienates itself. It can make of this alienation the motive of a terror from which it is necessary to protect itself to keep its ipséité, its identity, or then the structure of a desire: to want to be other, not to diminish or to increase itself compared to an origin which would be presence to oneself, but to feel the differential of this alienation.

The method of these alienated intelligences is the experimental, that is to say that in order to learn a thing it is necessary to do this thing, to be done with this thing, to tinker with it and thereby tinker with itself. The uncertainty of ipsity is then fully assumed and affirmed, and the strategies consisting in seeing AI as a plus or a minus become the grotesque scenes that try to preserve the fantasy of an intelligence considered as something not only precious, but divine.

Intelligence is granted an exceptionality to the human being that, in the course of its history, has consisted in attributing this intelligence or in denying it, not only to non-humans, but also to certain humans, racialized and colonized. It is this exceptionality granted to oneself by the faculty that one believes to be designated that must be deconstructed, because it is the privilege of a domination that shares the world. If some people want to protect human intelligence from AI, it is because it is fragile as well as precious, and if it disappears then the risk is mortal, since it would make humanity disappear purely and simply: by dint of dividing the world, we could well disappear in our turn.

The first two positions we have discussed are humanistic, reactionary on the left and liberal on the right, because they make the human being the only scale of value of all things. They do not imagine that AI could be an intelligence, but in a completely different sense than human intelligence, an alien intelligence that would refuse us. We would not be the paradigm and our “own” would not allow us to access it. In spite of certain evolutions of our sensibility these last years, we still have difficulty to consider fully the other intelligences and even to undo the privilege of this faculty on other modes of relations. We continue to scrutinize the world according to a logic of like and unlike, believing that the former has a higher dignity than the latter. It is not only anthropocentrism, it is a way of constituting the world as a world, of making the as such stand before itself from this precipice of reason.

There may be some joy in imagining this situation: human beings, having created a divine isolation of their species by believing themselves to be exceptional, produce machines that, inspired by the traces of their species, generate other types of reasoning, logic, and truths. At the end, because AI is in a way the end of a long process of cognitive externalization, we would be just as alone as at the beginning, but alone in another sense, according to another quality of solitude that we could qualify as alienation.

So of course, this should not lead us to romantically value mental alienation, because we have to distinguish, even if the limit is shaky, between an alienation that destroys the fragile reflexivity of an individual that prevents him from even posing a differentiation, and the alienation that can be an object of desire for reflexivity. What exactly is this desire? It is the desire, not the will, to lose oneself so that something other than oneself takes place: to be the hazardous occasion of another alienation than the one one one is already because one is a reflexive being. The reflection as thought of the thought, perception of the perception, memory of the memory, differentiation thus in the derridian sense, machine to defer and to archive that we are.

Faced with the great critical or fascinated narratives towards AI, the possibility of a completely different fiction opens up, that of alienated intelligences. By intelligence, we do not only mean the intelligence of the human being or that of the machine, but the difference between the two, that is to say the fact that this reciprocal alienation of the one and the other (I influence the AI as it influences me) puts in doubt the “of” that I placed before intelligence by designating an owner of it. This reflexive disappropriation of intelligence, in the gap of anthropotechnology, is not unrelated to the long historical process of externalization of rationality that I call the quartiary retention, adding it to the first three proposed by Bernard Stiegler.

Alienated intelligences are thus always in the plural: if I desire to be alienated by AI it is also because I desire to alienate it, and if I do not know who I am, I do not know who it is. I propose to mark this structural plurality, since it is the fruit of relationality, in the acronym AIs, a simple “s” as a way of introducing differentiation in AI. An intelligence is never alone, not only because it associates with other intelligences, but because they are only together. An intelligence is always alienated because if it dreams of its autonomy inscribed in the very heart of its reflexivity, it consists in sharing with others (intelligences). This relationality is in no way an oceanic confusion where there would be only one great Spirit. It coexists with the tearing between intelligences: we know well that this cat, whether it is GPT or animal, is intelligent, but while recognizing this faculty, we perceive its loneliness, our loneliness, because we will (perhaps) never manage to compose with our intelligences, we can only make the promise.