La machine est une enfance qui ne parle pas

L’enfance a été longtemps un modèle pour l’intelligence artificielle. Depuis la cybernétique des années 50, le choix se posait entre le fait de décrire de façon exhaustive un modèle d’intelligence et le fait de laisser la machine apprendre à la manière d’un enfant et passer du simple au complexe par elle-même.

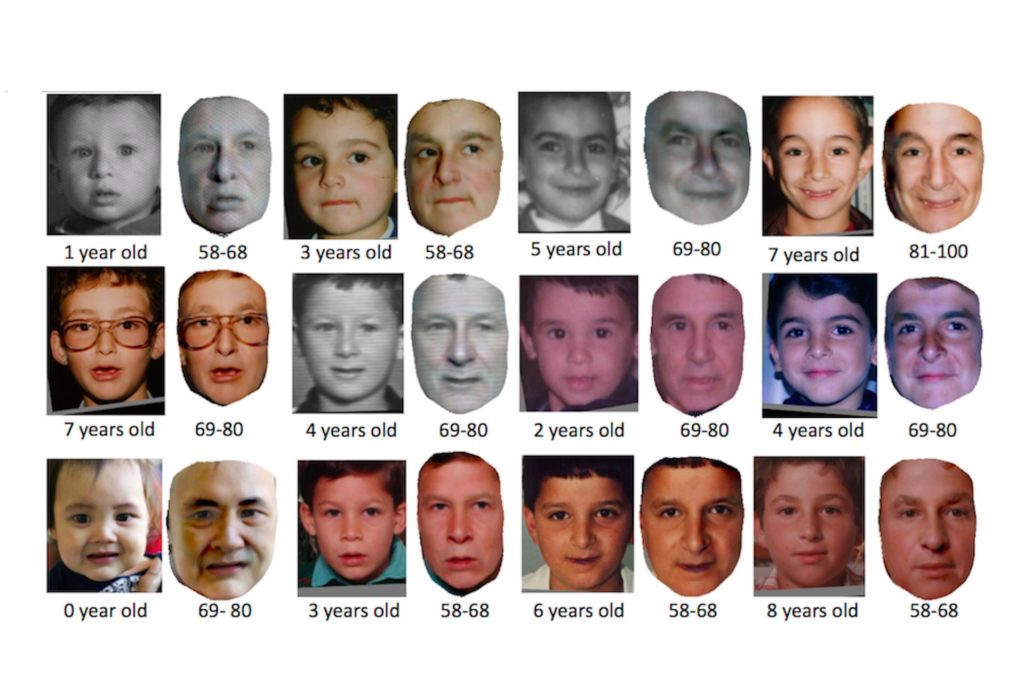

Norbert Wiener avait déjà développé ce modèle que nous retrouvons à présent dans le machine learning. Celui-ci reprend la métaphore de l’enfance, métaphore qui devient une opération fonctionnelle. Au départ, la machine sait très peu de choses, pour ainsi dire rien et en la nourrissant des données brutes qu’elle va vectoriser, elle va progressivement à apprendre à faire la même chose en y introduisant du bruit c’est-à-dire de la différence. L’enfance a toujours été liée à la connaissance comme son contre-exemple. L’enfant était l’insensé, l’esprit est un vide initial. C’est la métaphore de la cire chez Descartes, la table rase chez Bacon ou Locke, ou de l’enseignement chez Platon.

Derrière cette image enfantine, qui pourrait sembler simple se cache une réalité bien plus conflictuelle puisque l’enfance veut dire en latin celui qui ne parle pas. Infans est l’enfant avant le langage et ceux qui me connaissent comprendront aisément mon intérêt pour cette dimension. On comprend alors que l’usage de l’enfance dans l’intelligence artificielle consiste à faire parler cet enfant qui ne parle pas, à faire en sorte qu’il rendre des comptes au langage et aux adultes. il y a là une violence implicite que nous pouvons décrypter en prenant réellement la machine pour un enfant que les adultes tentent de soumettre.

La question qui dès lors se pose c’est de savoir que ferait une machine qui ne serait pas soumise à l’intelligence des adultes. Quelle langue parlerait-elle ? Ce souci de la singularité (en un sens différent de Kurzweil) de la machine au-delà de la projection anthropomorphique fut au cœur de la réflexion de Alan Turing qui, dans la seconde version de son célèbre test, tenta de mettre sur un pied d’égalité le simulacre technique et le simulacre humain en faisant prendre un homme pour une femme et une machine pour une femme. Homme et machine mentaient et c’est par une telle supercherie qu’une égalité entre les deux pouvait voir le jour.

La machine-enfant peut produire autre chose que ce qu’on y a mis, parce qu’on y a mis très peu et qu’on laisse la machine se développer, sans savoir ce qui se passe à l’intérieur d’elle. La machine-enfant n’est pas encore, elle est l’infans, elle peut dévier, elle est un clinamen. La meilleure façon de produire l’intelligence est de ne pas contrôler toutes ses conditions. Le possible de l’intelligence ne se programme pas. Les règles de départ sont minimales, les véritables règles du comportement émergeront du processus d’apprentissage, sans qu’on puisse en prédire le résultat. Il y a alors un principe d’autolimitation non programmatique de la machine. La « boîte noire » échappe à la détermination laplacienne parce que l’être humain a abandonné à son égard la posture divine de cause première. La machine lui est devenue opaque. L’introduction d’une composante aléatoire autolimitée dans le fonctionnement de la machine permet de comprendre que l’aléatoire n’est pas nécessairement absolu, auquel cas il deviendrait à son tour une loi, il peut être partiel. Être hors-la-loi c’est être hors de la loi et être hors de la non-loi. Tout peut devenir ou ne pas devenir, parce que l’individuation est chargée de préindividuel indéterminé. Ce savoir est spéculatif, tout comme l’est le code de l’ordinateur, parce que cette variabilité est seulement possible, factuellement telle ou telle chose se passe bien sûr de telle ou telle façon, le sensible est donc quant à lui relativement fixe, mais le savoir spéculatif de la contingence obtient avec l’ordinateur la capacité d’affecter les phénomènes.

J’aimerais rendre à la machine l’enfance dont elle provient. Non pas l’obliger à faire ce que je veux d’elle et croire qu’elle pourrait me recopier en me faisant faussement peur de ce remplacement mimétique, mais lui laisser balbutier selon ses propres possibilités. Le fait qu’il soit beaucoup plus difficile d’apprendre des fonctions simples que complexes à une machine est un signe de cette difficulté (https://en.m.wikipedia.org/wiki/Moravec%27s_paradox). La machine suivrait les fils du réseau et viendrait aspirer selon la contingence, le hasard d’une rencontre égarante, selon un sous-programme des données pour en produire d’autres que personne ne lui aura demandé. Il y aura alors peut être un événement, un seul sans nul regardeur. Ce possible, au moins, serait l’effectif.