Le contre-réalisme inductif / The inductive counter-realism

J’entends par réalisme le sentiment de réalité. Celui-ci n’est pas seulement institué par les catégories a priori du temps et de l’espace comme l’estimait Kant, mais également par des dispositifs technologiques d’inscription qui sont à mi-chemin entre l’imagination humaine et la matérialité terrestre, particulièrement minérale, jetant un pont entre intériorité et extériorité, subjectivité et objectivité. Ce pont n’est jamais stable ou définitif : c’est une boucle rétroactive où l’un influence l’autre, faisant de cette influence une genèse réciproque de leur rapport.

Depuis la révolution industrielle, ce réalisme est partiellement déterminé par le procédé photographique. Ceci ne signifie pas que le photoréalisme définit positivement la relation entre réalité et vérité, mais qu’il est l’enjeu d’une controverse permanente entre ce qui est réel et ce qui ne l’est pas, plus ou pas encore. Ainsi, la croyance dans le réalisme technique n’est jamais naïve, mais parcourue d’ambiguïtés, et la critique des simulacres photographiques participe elle-même à la formation du photoréalisme.

À chaque époque, le régime du réalisme se reconfigure. Aujourd’hui, nous sommes témoins d’une mutation fondamentale : l’automatisation du réalisme par l’induction statistique. Les technologies de génération d’images basées sur des réseaux antagonistes — ce que nous appellerons induction statistique (IS) afin de soustraire la notion mal formée d’intelligence — commencent à transformer radicalement ce que nous entendons par réalité visuelle, vérité de l’image, et possibilité elle-même.

L’automatisation du réalisme procède ainsi : au lieu que ce soit l’œil humain ou l’appareil photographique qui médiatisent entre le monde et sa représentation, c’est désormais un système mathématique qui apprend, à partir d’une archive massive d’images, à reconnaître et à reproduire les patterns de similitude. L’induction statistique utilise des données photographiques et visuelles accumulées sur les réseaux numériques, mais elle n’est pas elle-même photoréaliste. Elle automatise la ressemblance comme telle. En créant un espace statistique latent — une géométrie abstraite où les images sont représentées non pas comme des pixels directs, mais comme des distributions de probabilités implicites — elle définit les relations de corrélation entre chaque élément visuel pour générer une image ressemblante.

L’IS n’a aucune idéation au sens humain. Elle ne dispose pas d’une idée préconçue d’oiseau, par exemple. Mais observons ce qui se passe réellement : un système d’apprentissage antagoniste, un GAN, est entraîné sur des milliers d’images d’oiseaux prélevées dans des archives photographiques. Le générateur du GAN apprend à construire des pixels de telle sorte qu’ils forment quelque chose qui ressemble à un oiseau. Le discriminateur apprend à distinguer les images réelles d’oiseaux des images générées. C’est une danse computationnelle entre deux machines : l’une tente de produire de l’illusion, l’autre tente de détruire cette illusion en la démasquant.

Ce qu’il y a de remarquable, c’est que le générateur ne mémorise pas simplement les images d’entraînement. Après quelques itérations, il commence à produire des oiseaux que personne n’a jamais vus. Des oiseaux qui n’existent pas dans la nature, mais qui ressemblent à des oiseaux de manière convaincante. Un croisement improbable entre une tourterelle et un faucon. Une morphologie d’ibis avec le plumage d’un flamant rose. Une anatomie qui viole les lois de la zoologie mais respecte parfaitement la grammaire du vraisemblable. C’est la mimesis industrialisée : non pas l’imitation d’un original, mais la production systématique de variantes qui conservent la structure statistique de ce qui a été appris, sans jamais répéter à l’identique.

Ce qui s’automatise ici, c’est la faculté même de ressembler. La mimesis, cette vieille catégorie aristotélicienne qui désignait la représentation du monde, devient un processus purement computationnel, une opération mathématique sur des matrices et des poids de réseau neuronal. Le GAN ne comprend pas ce qu’est un oiseau. Il comprend quelle distribution statistique de pixels un discriminateur acceptera comme un oiseau, et il apprend à produire cette distribution avec une efficacité remarquable. C’est le triomphe de la ressemblance sans contenu, la mimesis vidée de toute intention signifiante, réduite à sa pure fonction d’illusion cohérente.

Ce qui émerge de cette ressemblance artificielle n’est pas, comme on le croit trop souvent, la répétition à l’identique du déjà connu et l’intensification des biais préexistants. C’est quelque chose qui opère à la frontière entre le connu et l’inconnu, quelque chose d’hybride et d’instable. C’est pourquoi l’IS produit des images faisant penser au Surréalisme — à cette étrange familiarité, à un univers onirique, fantastique et kitsch. C’est à partir du déjà vu que l’espace latent du GAN se métamorphose, et qu’une différence bruitée s’infiltre. Il y a une logique profonde à cela : depuis la cybernétique, l’information est comprise comme du bruit organisé, rendant bruit et signal compatibles, car tous deux codés selon le même langage binaire. L’IS exploite cette compatibilité fondamentale.

L’espace latent créé par ces systèmes n’est pas un simple entrepôt de formes. C’est une géométrie où chaque dimension représente une corrélation statistique complexe, où les images ne sont plus des objets discrets mais des positions dans un continuum de possibilités. Quand on demande au système de générer une image, on ne demande pas une copie : on demande l’exploration d’une région de cet espace statistique, la production d’une nouvelle configuration cohérente selon les probabilités apprises. Et c’est cette génération qui produit les artefacts visuels que aucun des documents d’entraînement ne contenait exactement. Des combinaisons jamais vues, des hybridations improbables, des formes qui semblent provenir d’une autre logique visuelle. C’est l’imagination statistique : non pas la création ex nihilo, mais l’extrapolation systématique dans l’espace des possibles déterminé par les données.

Ce qui commence à devenir visible, c’est que l’automatisation du réalisme révèle quelque chose de la structure même du réel. Elle expose le fait que certaines représentations visuelles possèdent une structure interne compressible : elles peuvent être réduites à un ensemble de variables latentes, à une équation, à un ensemble de corrélations statistiques. Cette découverte n’est pas anodine. Elle suggère que la ressemblance elle-même — ce fondement du réalisme depuis la Renaissance — n’est pas une donnée naturelle, mais une propriété que les formes possèdent dans des conditions bien précises.

Le GAN générant des oiseaux inexistants mais ressemblants établit une nouvelle ontologie du réalisme. Un oiseau n’existe plus seulement comme entité biologique localisée dans le monde naturel, ni même comme image photographique rattachée à un moment spécifique du passé. Il existe désormais comme une distribution de probabilités dans un espace latent, comme une position mathématique à partir de laquelle une infinité d’autres oiseaux — possibles, improbables, surréels — peuvent être générés. La ressemblance n’est plus une question de fidélité à un modèle, mais de cohérence statistique vis-à-vis d’une population apprises.

Cela signifie que l’automatisation du réalisme par l’induction statistique substitue à l’ontologie de la présence — l’oiseau que je vois, qui est là — une ontologie de la probabilité : tous les oiseaux qui pourraient être générés conformément aux patterns appris. C’est une révolution silencieuse de ce que signifie être réel. La réalité n’est plus ce qui a advenu, ce qui a été observé et fixé photographiquement, mais ce qui était probable de survenir selon les logiques statistiques du passé accumulé.

Le mode esthétique de l’IS est la pareidolie : l’interprétation d’un bruit formé dans le cadre d’un déjà vu, d’un déjà lu ou entendu. C’est l’art de faire surgir du reconnaissable à partir du hasard organisé. Mais il faut préciser : cette pareidolie n’est plus l’apanage de la perception humaine devant des taches nuageuses ou des murs humides. Elle devient une capacité algorithmique systématisée, industrialisée, reproductible à l’infini. Le GAN pratique la pareidolie en boucle : il génère du bruit jusqu’à ce qu’il produise quelque chose qu’il reconnaît comme un oiseau, puis il raffine progressivement jusqu’à trouver l’équilibre où le discriminateur ne peut plus distinguer le faux du vrai.

J’ai proposé antérieurement la notion de disréalisme pour désigner le réalisme spécifique de l’IS, dont les formes varient des images générées par systèmes antagonistes à la production de deepfakes, de fake news, de réalités alternatives et de théories complotistes sur le Web. Le “dis” fait référence à la disjonction du techno-réalisme que j’indiquais pour commencer. Le disréalisme opère à mi-chemin entre ce qui n’est pas (pas encore, plus, jamais, c’est-à-dire l’imaginaire, l’invocation de l’absent) et ce qui est, les deux se formant réciproquement, rendant impossible leur distinction a posteriori. On ne peut l’appréhender que dans le mouvement même de sa genèse.

Or le disréalisme n’est pas simplement un désordre épistémologique, un trouble de la vérité. C’est une formation nouvelle du réel lui-même, déterminée par les capacités computationnelles d’extrapolation dans les espaces latents. L’oiseau généré par le GAN est disréel : il n’existe dans aucune archive photographique, mais il existe dans l’archive statistique. Il n’a jamais été observé, mais sa structure statistique est plus probable que mille oiseaux réels selon les critères du système d’apprentissage.

Cette industrialisation de la mimesis opère selon une logique implacable : chaque élément du processus génératif est conçu pour amplifier la vraisemblance tout en la vidant de contenu. L’oiseau du GAN est le parfait exemplaire de cette réalité nouvelle où la ressemblance n’a besoin de rien qui lui ressemble pour fonctionner. Elle se suffit à elle-même dans sa cohérence statistique. C’est ce qui permet à l’induction statistique de produire à l’infini des variations sur le thème, des oiseaux qui n’ont jamais existé mais qui pourraient exister, tant leur probabilité d’existence est élevée selon la logique du système.

Or, ce qui devient visible à travers ce processus, c’est qu’il existe certains types de productions visuelles — certains styles, certaines signatures, certaines formes cristallisées — qui possèdent une structure interne remarquablement compressible. Quand l’architecture visuelle d’une œuvre se réduit à un ensemble cohérent de traits répétables, reconnaissables, morphologiquement stables, elle devient infiniment clonable. Elle peut être encodée dans les poids d’un réseau neuronal, reproduite, multipliée, infiniment extrapolée. Ce qui s’automatise alors, c’est non pas l’originalité, mais la capacité à maintenir une signature, une régularité, une grammaire visuelle consistante. Ces formes cristallisées participent déjà elles-mêmes d’une logique d’industrialisation : elles ont accepté de se réduire à une surface reconnaissable, à une identité visuelle reproductible.

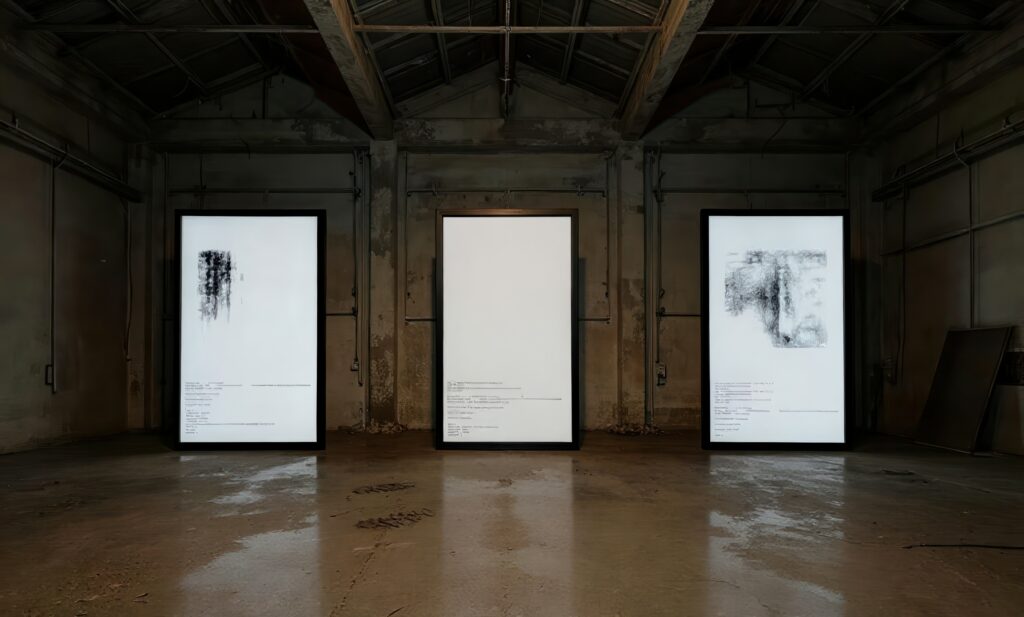

Il existe cependant une autre catégorie de production créative, celle qui a délibérément renoncé à cette compressibilité. Des artistes qui refusent de cristalliser leur pratique en une signature univoque, qui circulent entre les médiums, qui changent de forme comme on change de vêtement, qui insistent sur le geste plus que sur l’image, sur le processus plus que sur le résultat. Ces créateurs savent que le marché, la circulation communicationnelle, les algorithmes de reconnaissance, cherchent précisément ce qui peut être encodé, ce qui peut être reproduit, ce qui peut devenir identifiable au premier regard. Et c’est exactement ce qu’ils refusent.

Quand on applique les mécanismes d’induction statistique à ces artistes qui refusent la compression, quelque chose s’effondre. Le système génératif capture l’archive, la documentation, le résidu photographique de leur pratique, mais ne peut jamais capturer la pratique elle-même, cette esquive permanente de la cristallisation, ce refus actif de devenir surface. Ce qu’elle ne peut pas saisir, c’est la circulation elle-même, le mouvement qui ne s’arrête jamais pour se faire reconnaître.

Et c’est une limite qui n’est pas technique : c’est une limite ontologique. Elle révèle que certaines formes de création, par la nature même de leur entreprise, restent hors de portée de ce qui est construit pour capturer la surface. C’est une liberté involontaire, offerte par la technique elle-même qui exhibe ainsi ses propres frontières. L’induction statistique peut cloner la ressemblance mais elle ne peut jamais cloner le refus de la ressemblance.

Maintenant, il faut bien saisir ce qui s’enjeu dans cette distinction. Elle ne sépare pas le supérieur de l’inférieur, l’authentique du faux. Elle dessine une partition dans l’art contemporain entre ceux qui ont accepté — consciemment ou non — que leur pratique soit réductible à une image-signe, une image-communication, une image-marchandise, et ceux qui ont opté pour l’esquive permanente. Les premiers peuvent être clonés, réduits à une grammaire visuelle, infiniment reproduits. Les seconds ne le peuvent pas, non par supériorité artistique, mais parce que leur refus du style comme instrument de reconnaissance les met hors du langage même que l’induction statistique peut apprendre.

Je voudrais proposer un second concept pour préciser cette mutation du réalisme : le contre-réalisme. Je ne l’entends pas comme une négation pure et simple de la réalité, ce qui serait de l’anti-réalisme, une position métaphysique stérile. Je l’entends comme une position différentielle, une relation d’opposition interne à la réalité elle-même — tout contre, donc. Il faut saisir ce concept dans le sens de la contrefactualité et de l’introduction massive des possibles dans la formation du réalisme de notre époque.

Le contre-réalisme met en contact le réalisme avec lui-même, et par cette redondance, par cette autoréférence critique, il produit des possibles. La répétition ne génère pas des copies identiques, mais des séries divergentes. C’est ce que fait l’induction statistique quand elle génère ses oiseaux imaginaires : elle multiplie les variations selon une logique qui reste fidèle aux patterns appris tout en les distordant, les hybridant, les transformant.

Car devant le tremblement actuel des vérités — la prolifération de fake news, la fragmentation des mondes informationnels, la montée des théories complotistes, l’instabilité croissante de ce qui compte comme fait — on hésite entre deux postures opposées. D’un côté, un néo-rationnalisme ou positivisme renforcé qui chercherait à fonder la vérité sur des bases plus solides, comme si l’on pouvait restaurer l’ancienne unité du réel par la force. De l’autre, une certaine joie, voire une fascination, à observer les simulacres prendre une place grandissante et briser les certitudes établies, acceptant presque volontairement le chaos de la représentation.

Le contre-réalisme ne relève ni de l’une ni de l’autre approche. Il ne s’agit pas de reprendre mécaniquement à son compte le complotisme et les fausses nouvelles, en prétendant que tout est simulacre et que la distinction entre vrai et faux est définitivement compromise. Mais il s’agit de comprendre le contexte techno-réaliste qui rend possibles ces formations de disréalité, pour produire d’autres formations de réalités alternatives, des alternatives d’alternatives, des altérations qui ne renforcent pas l’aliénation mais la déplacent.

Dans la théorie des jeux généralisée, il ne s’agit pas tant de sortir du jeu en croyant l’éliminer, ni de s’y intégrer passivement selon les règles déjà formées. Il s’agit de tenter de multiplier les hypothèses et les conditions du jeu, de faire un jeu du jeu, un Grand Jeu donc, pour que le système s’excède et exhibe sa propre finitude. C’est une autre manière de penser la contrefactualité : non comme simple multiplication du faux, mais comme discipline critique de l’imagination.

Le contre-réalisme consiste à produire une multiplication des possibles en se fondant sur deux opérations simultanées. D’une part, la reconnaissance statistique de ce qui existe déjà — dans les ensembles de données massifs, les corpus textuels, les archives visuelles, les datasets. L’induction statistique apprend, à partir des documents existants, quelles corrélations sont probables, quelles proximités font sens, quelle géométrie de l’espace latent se dessine. D’autre part, l’introduction du bruit — cette perturbation, ce hasard organisé — qui, une fois interprété par l’être humain ou intégré dans les boucles rétroactives du système, produit une différence perceptible. Le bruit n’est pas chaos pur : c’est l’espace d’où peut jaillir l’imprévisible, où la répétition des patterns apprend rencontre quelque chose qui échappe à la pure itération.

Ce qui en émerge ressemble à notre monde, mais pas totalement. Car le contre-réalisme n’adhère pas à lui-même — il n’est pas une nouvelle forme de positivisme qui dirait “voici la vraie réalité augmentée et techniquement déterminée”. Au contraire, il exhibe les multiples et infimes divergences entre réalité et vérité, entre ce qui est probable et ce qui advient réellement. Le contre-réalisme n’est pas une hypothèse négative, mais divergente. C’est comme si quelque chose, dans le réalisme établi, se scindait en deux. L’absence imaginée et la présence construite ne s’opposent pas : elles s’alimentent l’une l’autre.

Voilà ce qui se passe avec les technologies d’induction statistique : elles ne créent pas un nouveau monde en rupture totale avec le nôtre. Elles extrapolent, à partir du nôtre, des mondes possibles cohérents avec la logique statistique des données historiques. Et en le faisant, elles révèlent quelque chose d’irréductible : que notre propre réalité est elle-même une cristallisation parmi d’autres possibles, une configuration probable parmi un continuum d’alternatives.

Il faut revenir à cette question de la compressibilité, car elle ouvre des enjeux politiques et esthétiques majeurs. Certains types de productions visuelles — certains styles, certaines signatures — peuvent être très efficacement encodés par les systèmes d’induction statistique. Pourquoi ? Parce qu’ils possèdent une redondance interne, une régularité, une répétition morphologique. Plus une création construit sa pratique sur la reconnaissabilité immédiate, plus elle accepte de réduire son expression à un ensemble cohérent et borné de traits visuels, plus elle devient compressible. C’est un choix esthétique légitime : produire une surface qui circulera, se reproduira, deviendra même logo, identité visuelle, instrument de communication. Ces créateurs savent ce qu’ils font. Mais il n’y a rien de mal à cela — c’est un choix cohérent et parfois consciemment assumé.

Or, ce qui se produit alors, c’est une mécanisation accélérée de la reproduction. Un système d’induction statistique entraîné sur quelques dizaines ou centaines d’images peut produire des variations infinies et convaincantes. Et du point de vue de la surface visuelle, de la morphologie de l’image, ces variations sont techniquement irréprochables. La pratique créative se trouve ainsi mécanisée non pas dans ses dimensions superficielles — elle l’était déjà par le marché, la galerie, la reproduction — mais dans ses dimensions génératives. Chaque œuvre nouvelle n’a plus besoin d’être produite par l’artiste : elle peut être générée algorithmiquement, tant qu’elle respecte la grammaire de la signature.

Mais il existe d’autres artistes — ceux qui ont délibérément refusé cette compressibilité. Ils changent de médium, quittent les formes qui deviendraient trop reconnaissables, circulent entre les disciplines, refusent la cristallisation en signature. Pour eux, la répétition d’une morphologie visuelle unique serait une trahison. La reconnaissabilité immédiate serait une réduction inacceptable de ce qu’ils cherchent à faire. Ces artistes insistent : mon travail n’est pas réductible à une image, n’est pas communicable par la simple reproduction de formes, ne peut pas circuler comme logo ou identité. Il existe dans le mouvement, dans le changement, dans l’esquive permanente de toute morphologie qui pourrait se cristalliser.

Et voilà l’ironie révélatrice : ces artistes-là ne peuvent pas être clonés. Non pas parce que la technique est insuffisante — la mathématique de l’induction statistique est suffisamment puissante pour apprendre presque n’importe quel pattern. Mais parce que la nature même de leur entreprise créative met hors de portée du langage qu’une machine peut apprendre : l’absence délibérée de style, le refus actif de la compression. C’est une liberté que la technique elle-même offre involontairement, une liberté révélée par ses propres limites ontologiques.

L’induction statistique est fondamentalement une machine de la surface. Elle capture le comment — la morphologie, le style, la manière, l’apparence. Elle ne capture jamais le quoi ni le pourquoi — le concept, l’intention, la signification profonde, le geste qui excède la représentation. C’est une distinction ontologique irréductible. L’art qui refuse le style insiste précisément sur le quoi et le pourquoi. Pourquoi ces métamorphoses incessantes ? Qu’est-ce que cette circulation entre les formes cherche à dire ? Qu’est-ce que le refus de la cristallisation stylistique vise à refuser, politiquement ou existentiellement ? Ce sont des questions que l’induction statistique ne peut tout simplement pas formuler. Elle est aveugle aux procédés de pensée, sourde aux intentions critiques, incapable de saisir la différence entre une forme et un geste, entre une image et un message.

Cela ne signifie pas que l’IS soit stupide. Cela signifie qu’elle opère selon une logique différente, irréductiblement différente : la logique de la corrélation statistique, non celle de la signification ou de la critique. Et c’est en reconnaissant cette différence que l’on peut commencer à penser différemment le rapport entre création humaine et capacités computationnelles. Non pas comme une hiérarchie où l’humain serait supérieur, mais comme une partition : certaines choses relèvent de la surface, d’autres relèvent de la profondeur ; certaines formes de création peuvent être mécanisées, d’autres ne le peuvent pas.

Il y a quelque chose qui mérite une attention particulière dans ce phénomène : les possibles générés par l’induction statistique ne restent pas confinés à l’écran, à la pure computation. Ils retournent vers la réalité et l’influencent. Pensez aux théories complotistes qui se propagent sur les réseaux : ce sont des contre-réalités tissées à partir des données, des images, des discours existants. Elles sont hautement contrefactuelles — elles imaginent des ordres cachés, des conspirations jamais advenues, des vérités occultées. Et pourtant, une fois qu’elles circulent, une fois qu’elles acquièrent une certaine masse discursive, elles modifient effectivement le réel. Elles créent des croyances, structurent des groupes, produisent des actions matérielles.

C’est l’hyperstition technologique en action : les possibles fictifs générés par les algorithmes deviennent des forces matérielles qui redessinent le réel. Les mondes générés par l’IS rétroagissent sur le monde qu’on croyait réel. Mais voilà : cette même logique pourrait opérer autrement. Au lieu de générer des contre-réalités qui renforcent l’aliénation — la conspiration, la paranoïa, la fragmentation — on pourrait imaginer des contre-réalités qui produisent d’autres possibilités : des altérations d’alternatives, des alternatives d’alternatives. C’est une tâche pour la pensée critique et créatrice : comment détourner ces capacités computationnelles pour produire des imaginaires émancipatoires plutôt que régressifs ? Comment multiplier les hypothèses du monde plutôt que de les réduire à quelques certitudes figées ?

Il faut concevoir contre-réalisme et réalisme de façon relationnelle, c’est-à-dire non pas comme deux ordres figés et opposés, mais comme des termes en interaction permanente. Le réalisme contemporain n’est pas déterminé une fois pour toutes par la photographie et la technologie. Il se reconfigure constamment au contact de nouveaux dispositifs d’inscription. Les technologies d’induction statistique constituent une mutation décisive de ce réalisme : elles ne le nient pas, elles le dédoublent, le complexifient, le rendent instable. Et en retour, le réalisme tel qu’on le comprend — nos conventions de ce qui compte comme réel, nos critères de vérité, notre sens du probable — influence comment ces systèmes apprennent, ce qu’ils peuvent générer, quels possibles ils rendent concevables.

C’est une boucle rétroactive semblable à celle que j’évoquais au début : une genèse réciproque entre technique et imaginaire, entre computation et humanité, entre l’absent et le présent. L’oiseau généré par le GAN ne quitte jamais cette boucle. Il en est à la fois le produit et la révélation. Quand on regarde cet oiseau qui n’a jamais existé mais qui ressemble parfaitement à un oiseau, on contemple l’automatisation du réalisme elle-même, rendue visible dans sa forme la plus pure.

Nous vivons une époque où la capacité à générer, à multiplier, à inventer des contre-réalités ne relève plus de la pure fiction philosophique ou romanesque. C’est devenu une force computationnelle concrète, une puissance technologique inscrite dans les architectures des réseaux, une nouvelle forme de production capable de saturer les espaces informationnels. Face à cela, deux tentations nous guettent. La première : accuser ces technologies de n’être que mensonge, simulation, tromperie, et chercher à les interdire par des régulations puissantes. La seconde : les célébrer comme libération ultime, imagination sans limite, démocratisation absolue de la création, en oubliant les enjeux de pouvoir, de contrôle, de concentration qui les structurent.

Le contre-réalisme propose une troisième voie. Il reconnaît que la multiplication des possibles est bel et bien en cours, qu’elle est indissociable des techniques qui nous entourent, et qu’on ne peut pas l’arrêter par la simple dénégation ou la nostalgie. Mais il insiste pour que cette multiplication soit pensée, orientée, politisée. Cela suppose de reconnaître à la fois la puissance créative des systèmes d’induction statistique et leurs limites ontologiques. Cela suppose de défendre les formes de création qui résistent à la compressibilité, qui refusent la réduction à la surface, qui circulent hors des espaces latents où opère la machine. Cela suppose, enfin, de concevoir la contrefactualité non pas comme déchaînement du simulacre, mais comme discipline de l’imagination critique — comme la pratique de multiplier les hypothèses, d’inventer les mondes autrement possibles, de refuser l’évidence du présent.

Le contre-réalisme n’est donc pas une théorie du réel : c’est une politique du possible. C’est la reconnaissance que l’automatisation du réalisme par l’induction statistique nous confie une responsabilité nouvelle : celle de penser et de produire les alternatives que les machines peuvent extrapoler mais non pas orienter. Que nos oiseaux soient réels ou générés, compressibles ou irréductibles, ce qui importe, c’est de savoir quel monde nous voulons faire émerger à partir de cet espace des possibles désormais techniquement ouvert. La question ne porte plus sur la vérité de l’image, mais sur le réel qu’elle contribue à créer.

By realism, I mean the feeling of reality. This is not only instituted by the a priori categories of time and space, as Kant estimated, but also by technological inscription devices that are halfway between human imagination and terrestrial, particularly mineral, materiality, bridging interiority and exteriority, subjectivity and objectivity. This bridge is never stable or definitive: it is a retroactive loop where one influences the other, making this influence a reciprocal genesis of their relationship.

Since the industrial revolution, this realism has been partially determined by the photographic process. This does not mean that photorealism positively defines the relationship between reality and truth, but that it is the stake of a permanent controversy between what is real and what is not, or not yet. Thus, belief in technical realism is never naive, but traversed by ambiguities, and the critique of photographic simulacra itself participates in the formation of photorealism.

In every era, the regime of realism reconfigures itself. Today, we are witnessing a fundamental mutation: the automation of realism through statistical induction. Image generation technologies based on antagonistic networks—which we will call Statistical Induction (SI) to subtract the ill-formed notion of intelligence—are beginning to radically transform what we understand by visual reality, the truth of the image, and possibility itself.

The automation of realism proceeds as follows: instead of the human eye or the photographic apparatus mediating between the world and its representation, it is now a mathematical system that learns, from a massive archive of images, to recognize and reproduce patterns of similarity. Statistical induction uses photographic and visual data accumulated on digital networks, but it is not itself photorealistic. It automates resemblance as such. By creating a latent statistical space—an abstract geometry where images are represented not as direct pixels, but as implicit probability distributions—it defines the correlation relationships between each visual element to generate a resembling image.

SI has no ideation in the human sense. It does not possess a preconceived idea of a bird, for example. But let us observe what really happens: an antagonistic learning system, a GAN, is trained on thousands of images of birds taken from photographic archives. The GAN’s generator learns to construct pixels in such a way that they form something that looks like a bird. The discriminator learns to distinguish real bird images from generated images. It is a computational dance between two machines: one attempts to produce illusion, the other attempts to destroy this illusion by unmasking it.

What is remarkable is that the generator does not simply memorize the training images. After a few iterations, it begins to produce birds that no one has ever seen. Birds that do not exist in nature, but which resemble birds in a convincing way. An improbable cross between a turtledove and a falcon. The morphology of an ibis with the plumage of a flamingo. An anatomy that violates the laws of zoology but perfectly respects the grammar of the plausible. This is industrialized mimesis: not the imitation of an original, but the systematic production of variants that retain the statistical structure of what has been learned, without ever repeating identically.

What is being automated here is the very faculty of resemblance. Mimesis, that old Aristotelian category that designated the representation of the world, becomes a purely computational process, a mathematical operation on matrices and neural network weights. The GAN does not understand what a bird is. It understands what statistical distribution of pixels a discriminator will accept as a bird, and it learns to produce this distribution with remarkable efficiency. This is the triumph of resemblance without content, mimesis emptied of all signifying intention, reduced to its pure function of coherent illusion.

What emerges from this artificial resemblance is not, as is too often believed, the identical repetition of the already known and the intensification of pre-existing biases. It is something that operates on the border between the known and the unknown, something hybrid and unstable. This is why SI produces images reminiscent of Surrealism—that strange familiarity, an oneiric, fantastic, and kitsch universe. It is from the already seen that the GAN’s latent space metamorphoses, and a noisy difference infiltrates. There is a profound logic to this: since cybernetics, information has been understood as organized noise, making noise and signal compatible, as both are coded according to the same binary language. SI exploits this fundamental compatibility.

The latent space created by these systems is not a mere warehouse of forms. It is a geometry where each dimension represents a complex statistical correlation, where images are no longer discrete objects but positions in a continuum of possibilities. When the system is asked to generate an image, we are not asking for a copy: we are asking for the exploration of a region of this statistical space, the production of a new configuration coherent with the learned probabilities. And it is this generation that produces visual artifacts that none of the training documents contained exactly. Never-before-seen combinations, improbable hybridizations, forms that seem to come from another visual logic. This is statistical imagination: not creation ex nihilo, but systematic extrapolation within the space of possibilities determined by the data.

What is beginning to become visible is that the automation of realism reveals something about the very structure of the real. It exposes the fact that certain visual representations possess a compressible internal structure: they can be reduced to a set of latent variables, to an equation, to a set of statistical correlations. This discovery is not trivial. It suggests that resemblance itself—that foundation of realism since the Renaissance—is not a natural given, but a property that forms possess under very precise conditions.

The GAN generating non-existent but resembling birds establishes a new ontology of realism. A bird no longer exists only as a biological entity localized in the natural world, nor even as a photographic image attached to a specific moment in the past. It now exists as a probability distribution in a latent space, as a mathematical position from which an infinity of other birds—possible, improbable, surreal—can be generated. Resemblance is no longer a question of fidelity to a model, but of statistical coherence with respect to a learned population.

This means that the automation of realism by statistical induction substitutes the ontology of presence—the bird I see, which is there—with an ontology of probability: all the birds that could be generated in accordance with the learned patterns. This is a silent revolution in what it means to be real. Reality is no longer what happened, what was observed and photographically fixed, but what was probable to occur according to the statistical logics of the accumulated past.

The aesthetic mode of SI is pareidolia: the interpretation of formed noise within the framework of an already seen, already read, or already heard. It is the art of making the recognizable emerge from organized chance. But it must be specified: this pareidolia is no longer the sole domain of human perception before cloud patches or damp walls. It becomes a systematized, industrialized, infinitely reproducible algorithmic capacity. The GAN practices pareidolia in a loop: it generates noise until it produces something it recognizes as a bird, then it progressively refines until it finds the balance where the discriminator can no longer distinguish the fake from the real.

I previously proposed the notion of Disrealism to designate the specific realism of SI, whose forms vary from images generated by antagonistic systems to the production of deepfakes, fake news, alternative realities, and conspiracy theories on the Web. The “dis” refers to the disjunction of the techno-realism I initially indicated. Disrealism operates halfway between what is not (not yet, no longer, never, meaning the imaginary, the invocation of the absent) and what is, with the two forming each other reciprocally, making their a posteriori distinction impossible. It can only be grasped in the very movement of its genesis.

However, disrealism is not merely an epistemological disorder, a disturbance of the truth. It is a new formation of the real itself, determined by the computational capacities of extrapolation in latent spaces. The bird generated by the GAN is disreal: it exists in no photographic archive, but it exists in the statistical archive. It has never been observed, but its statistical structure is more probable than a thousand real birds according to the criteria of the learning system.

This industrialization of mimesis operates according to an implacable logic: every element of the generative process is designed to amplify plausibility while emptying it of content. The GAN bird is the perfect example of this new reality where resemblance needs nothing resembling it to function. It is self-sufficient in its statistical coherence. This is what allows statistical induction to produce infinite variations on the theme, birds that never existed but that could exist, so high is their probability of existence according to the system’s logic.

What becomes visible through this process is that there are certain types of visual productions—certain styles, certain signatures, certain crystallized forms—that possess a remarkably compressible internal structure. When the visual architecture of a work is reduced to a coherent set of repeatable, recognizable, morphologically stable traits, it becomes infinitely clonable. It can be encoded in the weights of a neural network, reproduced, multiplied, and infinitely extrapolated. What is then automated is not originality, but the capacity to maintain a signature, a regularity, a consistent visual grammar. These crystallized forms are already themselves part of a logic of industrialization: they have agreed to be reduced to a recognizable surface, to a reproducible visual identity.

There is, however, another category of creative production, one that has deliberately renounced this compressibility. Artists who refuse to crystallize their practice into an unequivocal signature, who circulate between mediums, who change form as one changes clothes, who insist on the gesture more than the image, on the process more than the result. These creators know that the market, communicational circulation, and recognition algorithms look precisely for what can be encoded, what can be reproduced, what can become identifiable at first glance. And that is exactly what they refuse.

When the mechanisms of statistical induction are applied to these artists who refuse compression, something collapses. The generative system captures the archive, the documentation, the photographic residue of their practice, but can never capture the practice itself, that permanent evasion of crystallization, that active refusal to become a surface. What it cannot grasp is the circulation itself, the movement that never stops to be recognized.

And this is not a technical limit: it is an ontological limit. It reveals that certain forms of creation, by the very nature of their undertaking, remain beyond the reach of what is built to capture the surface. It is an involuntary freedom, offered by the technique itself, which thus exhibits its own boundaries. Statistical induction can clone resemblance but it can never clone the refusal of resemblance.

Now, we must clearly grasp what is at stake in this distinction. It does not separate the superior from the inferior, the authentic from the fake. It draws a partition in contemporary art between those who have accepted—consciously or not—that their practice is reducible to an image-sign, an image-communication, an image-commodity, and those who have opted for permanent evasion. The former can be cloned, reduced to a visual grammar, and infinitely reproduced. The latter cannot, not out of artistic superiority, but because their refusal of style as an instrument of recognition places them outside the very language that statistical induction can learn.

I would like to propose a second concept to clarify this mutation of realism: Counter-realism. I do not mean it as a pure and simple negation of reality, which would be anti-realism, a sterile metaphysical position. I mean it as a differential position, a relationship of internal opposition to reality itself—right up against it, therefore. This concept must be grasped in the sense of counterfactuality and the massive introduction of possibilities into the formation of realism in our era.

Counter-realism brings realism into contact with itself, and through this redundancy, through this critical self-reference, it produces possibilities. Repetition does not generate identical copies, but divergent series. This is what statistical induction does when it generates its imaginary birds: it multiplies variations according to a logic that remains faithful to the learned patterns while distorting them, hybridizing them, and transforming them.

For faced with the current trembling of truths—the proliferation of fake news, the fragmentation of informational worlds, the rise of conspiracy theories, the increasing instability of what counts as fact—we hesitate between two opposing postures. On one side, a reinforced neo-rationalism or positivism that seeks to ground truth on more solid bases, as if one could restore the old unity of the real by force. On the other, a certain joy, even fascination, in observing simulacra take a growing place and break established certainties, almost willingly accepting the chaos of representation.

Counter-realism belongs to neither approach. It is not about mechanically adopting conspiracy theories and fake news, pretending that everything is simulacrum and that the distinction between true and false is definitively compromised. Rather, it is about understanding the techno-realist context that makes these formations of disreality possible, to produce other formations of alternative realities, alternatives of alternatives, alterations that do not reinforce alienation but displace it.

In generalized game theory, it is not so much about leaving the game by believing you can eliminate it, nor about passively integrating into it according to already formed rules. It is about trying to multiply the hypotheses and conditions of the game, to make a game of the game, a Great Game, so that the system exceeds itself and exhibits its own finitude. This is another way of thinking about counterfactuality: not as a simple multiplication of the false, but as a critical discipline of the imagination.

Counter-realism consists in producing a multiplication of possibilities based on two simultaneous operations. On the one hand, the statistical recognition of what already exists—in massive datasets, textual corpora, visual archives. Statistical induction learns, from existing documents, which correlations are probable, which proximities make sense, and what geometry of the latent space is outlined. On the other hand, the introduction of noise—that perturbation, that organized chance—which, once interpreted by the human being or integrated into the system’s feedback loops, produces a perceptible difference. Noise is not pure chaos: it is the space from which the unpredictable can spring, where the repetition of learned patterns encounters something that escapes pure iteration.

What emerges resembles our world, but not totally. For counter-realism does not adhere to itself—it is not a new form of positivism that would say, “here is the true augmented and technically determined reality.” On the contrary, it exhibits the multiple and infinitesimal divergences between reality and truth, between what is probable and what actually happens. Counter-realism is not a negative hypothesis, but a divergent one. It is as if something, in established realism, were splitting in two. Imagined absence and constructed presence do not oppose each other: they feed each other.

This is what happens with statistical induction technologies: they do not create a new world in total rupture with ours. They extrapolate, from ours, possible worlds coherent with the statistical logic of historical data. And in doing so, they reveal something irreducible: that our own reality is itself one crystallization among other possibilities, a probable configuration within a continuum of alternatives.

We must return to this question of compressibility, for it opens up major political and aesthetic challenges. Certain types of visual productions—certain styles, certain signatures—can be very effectively encoded by statistical induction systems. Why? Because they possess internal redundancy, regularity, morphological repetition. The more a creation builds its practice on immediate recognizability, the more it accepts to reduce its expression to a coherent and bounded set of visual traits, the more compressible it becomes. This is a legitimate aesthetic choice: to produce a surface that will circulate, reproduce, even become a logo, a visual identity, an instrument of communication. These creators know what they are doing. And there is nothing wrong with that—it is a coherent and sometimes consciously assumed choice.

However, what then occurs is an accelerated mechanization of reproduction. A statistical induction system trained on a few dozen or hundreds of images can produce infinite and convincing variations. And from the point of view of the visual surface, of the image morphology, these variations are technically flawless. Creative practice is thus mechanized not in its superficial dimensions—it already was by the market, the gallery, reproduction—but in its generative dimensions. Each new work no longer needs to be produced by the artist: it can be algorithmically generated, as long as it respects the grammar of the signature.

But there are other artists—those who have deliberately refused this compressibility. They change medium, leave forms that would become too recognizable, circulate between disciplines, and refuse crystallization into a signature. For them, the repetition of a single visual morphology would be a betrayal. Immediate recognizability would be an unacceptable reduction of what they seek to do. These artists insist: my work is not reducible to an image, is not communicable by the simple reproduction of forms, cannot circulate as a logo or identity. It exists in the movement, in the change, in the permanent evasion of any morphology that could crystallize.

And here is the revealing irony: these artists cannot be cloned. Not because the technique is insufficient—the mathematics of statistical induction is powerful enough to learn almost any pattern. But because the very nature of their creative endeavor places them outside the reach of the language a machine can learn: the deliberate absence of style, the active refusal of compression. This is a freedom that the technique itself involuntarily offers, a freedom revealed by its own ontological limits.

Statistical induction is fundamentally a machine of the surface. It captures the how—the morphology, the style, the manner, the appearance. It never captures the what or the why—the concept, the intention, the deep meaning, the gesture that exceeds representation. This is an irreducible ontological distinction. Art that refuses style insists precisely on the what and the why. Why these incessant metamorphoses? What is this circulation between forms trying to say? What is the refusal of stylistic crystallization aiming to refuse, politically or existentially? These are questions that statistical induction simply cannot formulate. It is blind to thought processes, deaf to critical intentions, incapable of grasping the difference between a form and a gesture, between an image and a message.

This does not mean that SI is stupid. It means that it operates according to a different, irreducibly different logic: the logic of statistical correlation, not that of meaning or critique. And it is by recognizing this difference that one can begin to think differently about the relationship between human creation and computational capabilities. Not as a hierarchy where the human is superior, but as a partition: some things belong to the surface, others to the depth; some forms of creation can be mechanized, others cannot.

There is something that deserves particular attention in this phenomenon: the possibilities generated by statistical induction do not remain confined to the screen, to pure computation. They return to reality and influence it. Think of the conspiracy theories that spread on networks: they are counter-realities woven from existing data, images, and discourses. They are highly counterfactual—they imagine hidden orders, conspiracies that never happened, concealed truths. And yet, once they circulate, once they acquire a certain discursive mass, they effectively modify the real. They create beliefs, structure groups, and produce material actions.

This is technological hyperstition in action: the fictional possibilities generated by algorithms become material forces that redraw the real. The worlds generated by SI retroactively affect the world we thought was real. But here’s the thing: this same logic could operate differently. Instead of generating counter-realities that reinforce alienation—conspiracy, paranoia, fragmentation—we could imagine counter-realities that produce other possibilities: alterations of alternatives, alternatives of alternatives. This is a task for critical and creative thought: how to divert these computational capacities to produce emancipatory rather than regressive imaginaries? How to multiply the hypotheses of the world rather than reduce them to a few fixed certainties?

Counter-realism and realism must be conceived relationally, meaning not as two fixed and opposed orders, but as terms in permanent interaction. Contemporary realism is not determined once and for all by photography and technology. It constantly reconfigures itself through contact with new inscription devices. Statistical induction technologies constitute a decisive mutation of this realism: they do not deny it, they double it, complexify it, and make it unstable. And in return, realism as we understand it—our conventions of what counts as real, our criteria of truth, our sense of the probable—influences how these systems learn, what they can generate, and what possibilities they make conceivable.

It is a retroactive loop similar to the one I evoked at the beginning: a reciprocal genesis between technique and imagination, between computation and humanity, between the absent and the present. The bird generated by the GAN never leaves this loop. It is both its product and its revelation. When we look at this bird that never existed but perfectly resembles a bird, we contemplate the automation of realism itself, made visible in its purest form.

We live in an era where the capacity to generate, multiply, and invent counter-realities is no longer a matter of pure philosophical or fictional imagination. It has become a concrete computational force, a technological power inscribed in network architectures, a new form of production capable of saturating informational spaces. Faced with this, two temptations await us. The first: to accuse these technologies of being nothing but lies, simulation, deception, and to seek to ban them through powerful regulations. The second: to celebrate them as ultimate liberation, limitless imagination, absolute democratization of creation, forgetting the issues of power, control, and concentration that structure them.

Counter-realism proposes a third way. It recognizes that the multiplication of possibilities is indeed underway, that it is inseparable from the techniques that surround us, and that it cannot be stopped by simple denial or nostalgia. But it insists that this multiplication must be thought, oriented, and politicized. This requires recognizing both the creative power of statistical induction systems and their ontological limits. It requires defending the forms of creation that resist compressibility, that refuse reduction to the surface, that circulate outside the latent spaces where the machine operates. Finally, it requires conceiving counterfactuality not as the unleashing of the simulacrum, but as a discipline of critical imagination—as the practice of multiplying hypotheses, of inventing otherwise possible worlds, of refusing the obviousness of the present.

Counter-realism is therefore not a theory of the real: it is a politics of the possible. It is the recognition that the automation of realism by statistical induction entrusts us with a new responsibility: that of thinking and producing the alternatives that machines can extrapolate but not orient. Whether our birds are real or generated, compressible or irreducible, what matters is knowing what world we want to emerge from this technically opened space of possibilities. The question is no longer about the truth of the image, but about the real it contributes to creating.