Quand la lecture précèdera l’écriture / When reading will precede writing

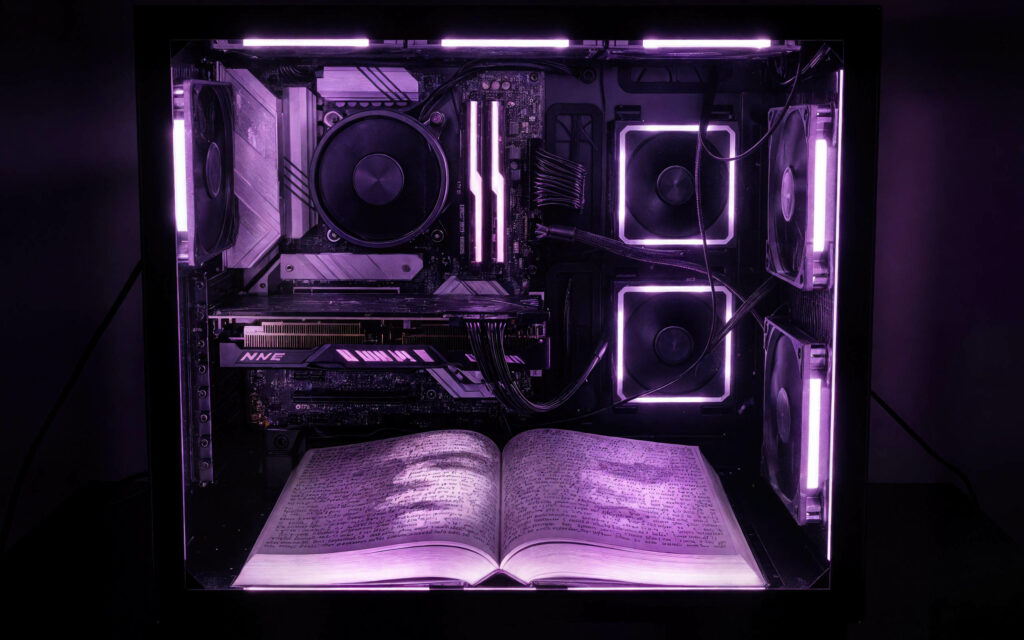

L’intelligence artificielle générative bouleverse-t-elle seulement nos outils d’écriture ou transforme-t-elle radicalement notre rapport à la création littéraire ? Cette étude explore comment les modèles de langage actuels actualisent les intuitions théoriques de Roland Barthes sur le « texte scriptible » et opèrent une inversion temporelle fondamentale : nous lisons désormais avant d’écrire.

Dans un monde où ChatGPT peut générer un roman en quelques minutes et où des millions d’utilisateurs collaborent quotidiennement avec des algorithmes pour produire du texte, la frontière traditionnelle entre lecture et écriture s’estompe. Cette transformation n’est pas seulement technique : elle révèle l’artificialité de nos propres automatismes créatifs et nous confronte à une altérité textuelle inédite. Cette inversion semble comme actualiser l’intuition de Foucault dans “L’ordre du discours” : le désir de “pouvoir me glisser subrepticement” dans la parole, d’être “enveloppé par elle, et porté bien au-delà de tout commencement possible”. L’IA générative réalise concrètement cette utopie foucaldienne d’un sujet qui ne précède pas son énonciation mais émerge de sa rencontre avec un discours toujours-déjà là.

S’appuyant sur la théorie de la réception, la philosophie technique de Bernard Stiegler et les analyses poststructuralistes de Barthes et Kristeva, cet essai examine comment l’IA générative concrétise l’utopie barthésienne du « lecteur-producteur » tout en introduisant de nouvelles formes de mémoire technique. L’espace latent vectoriel des modèles de langage fonctionne comme cette « galaxie de signifiants » que Barthes appelait de ses vœux, où le sens émerge de la projection plutôt que de la réception.

Mais cette révolution soulève des questions existentielles profondes. Comment aimer un texte sans s’y retrouver entièrement ? Que signifie créer dans l’instabilité, quand nos partenaires algorithmiques peuvent être modifiés du jour au lendemain ? L’analyse s’achève sur le cas tragique de ce jeune homme qui développa un attachement fatal à un personnage généré par IA, illustrant les enjeux affectifs de notre nouvelle condition littéraire.

Entre fascination et inquiétude, cet essai invite à repenser ce que signifie écrire et lire à l’ère des machines apprenantes, où la littérature devient le laboratoire d’une expérimentation collective entre humains et algorithmes.

–

Roland Barthes, dans S/Z, avait proposé une conception du texte en distinguant entre le texte « lisible » et le texte « scriptible ». Le texte scriptible, écrivait-il, « c’est nous en train d’écrire », un espace où « le lecteur n’est plus un consommateur, mais un producteur du texte ». Cette vision préfigurait ce que nous expérimentons aujourd’hui à grande échelle avec l’intelligence artificielle générative et les LLM : un renversement paradoxal de la chronologie où la lecture précède l’écriture.

Le texte lisible était pour Barthes « un produit (et non une production) », caractérisé par sa « valeur commerciale » et sa capacité à être « lu, mais non écrit ». À l’inverse, le texte scriptible constituait « une galaxie de signifiants, non une structure de signifiés ; il n’a pas de commencement ; il est réversible ; on y accède par plusieurs entrées dont aucune ne peut être à coup sûr déclarée principale ». Cette description trouve dans les modèles génératifs contemporains une actualisation technologique saisissante : l’espace latent vectoriel fonctionne précisément comme cette « galaxie de signifiants » où chaque point peut devenir le début d’un texte potentiel. Foucault avait diagnostiqué cette réduction du discours “à l’ordre du signifiant” comme problématique lorsqu’elle “annule” la réalité matérielle du discours. Mais l’IA générative transforme cette critique en potentiel : l’espace vectoriel ne supprime pas l’événementialité du discours, mais en la multipliant et en rendant chaque génération imprévisible, il épuise sa singularité jusqu’à disparition de la saillance de l’événement.

L’IA nous donne en effet à lire ce qui n’a pas encore été écrit. Lorsque, face à ces lettres, mots, phrases générées, je me dis que j’aurais pu les écrire, si j’en suis curieux, amoureux ou même jaloux, alors je peux les copier, les éditer, les corriger, les publier. Cette édition constitue une forme d’écriture postérieure à la lecture qui transforme ma prétendue intériorité dont l’écriture aurait été le signe. L’IA actualise ainsi la vision du lecteur-producteur, mais dans un contexte technologique qui démontre le caractère artificieux de l’intelligence.

La dimension émotionnelle de la reconnaissance textuelle mérite d’être soulignée. Quand Barthes évoque la « jouissance du texte », il décrit précisément cette capacité du lecteur à être affecté par ce qu’il lit au point de vouloir le reproduire, le transformer, le faire sien. Avec l’IA générative, cette jouissance change de nature : elle ne naît plus de la reconnaissance d’une humanité partagée avec l’auteur, mais de la surprise de découvrir que quelque chose de non-humain, ou plus exactement à sa limite, peut néanmoins nous toucher, nous interpeller, nous donner envie d’écrire à notre tour. Cette mutation affective trouve une explication dans les mécanismes d’alignement des IA : les systèmes sont désormais entraînés à reproduire nos préférences esthétiques et morales par millions d’exemples. L’algorithme apprend littéralement nos goûts, nos phobies, nos désirs stylistiques. Quand nous sommes touchés par un texte IA, nous reconnaissons inconsciemment nos propres patterns de plaisir, mais transformés et défamiliarisés. L’émotion naît de cette reconnaissance troublante : c’est notre propre sensibilité qui nous revient, amplifiée et rendue étrangère par le calcul.

Cette inversion bouleverse l’un des fondements les plus élémentaires et logiques de notre rapport à la littérature. Dans la conception traditionnelle, l’écriture précède logiquement la lecture : l’auteur produit d’abord un texte que le lecteur découvre ensuite. Mais avec l’IA générative, un renversement émerge où la lecture précède l’écriture, montrant que nous cherchons dans l’algorithme un autre nous-mêmes, comme si l’écriture et la lecture établissaient fantasmatiquement cette réciprocité de la communauté humaine.

Cette recherche de l’autre en soi prend avec l’IA une dimension vertigineuse. Nous projetons sur l’algorithme nos attentes anthropomorphiques, nos désirs de reconnaissance, notre besoin de dialogue. Mais l’algorithme nous renvoie quelque chose de différent : non pas l’autre comme soi, mais le soi comme autre. Il nous montre ce que nous aurions pu écrire si nous avions été légèrement différents, si nous avions lu d’autres livres, si nous avions vécu d’autres vies. Cette altérité familière déstabilise nos catégories habituelles et nous force à repenser ce que signifie « reconnaître » un texte.

La critique de la réception avait déjà commencé à questionner cette hiérarchie traditionnelle. Wolfgang Iser et Hans Robert Jauss (1980) montraient que le sens du texte émerge dans l’acte de lecture, que le lecteur participe activement à la construction du sens. L’IA pousse cette logique à son terme : le texte n’existe littéralement que par et pour sa lecture, dans une temporalité du « déjà-lu ».

Iser avait développé le concept de « lecteur implicite », cette instance textuelle qui guide l’actualisation du sens par le lecteur empirique. Avec l’IA, cette distinction s’effondre : le « lecteur implicite » devient littéralement le lecteur empirique qui, par ses prompts et ses interactions, configure en temps réel les paramètres de génération du texte. La notion d’« horizon d’attente » de Jauss se trouve également transformée : au lieu de s’appuyer sur un contexte historique et culturel partagé, l’horizon d’attente devient algorithmique, déterminé par les patterns statistiques du modèle et les instructions de l’utilisateur.

La prédiction

La théorie prédictive de l’esprit, développée par Andy Clark, offre un cadre conceptuel fécond pour appréhender cette transformation. Selon Clark, le cerveau humain fonctionne comme une machine à prédictions qui projette constamment ses attentes sur le flux sensoriel. La perception n’est pas une réception passive d’informations, mais une « hallucination contrôlée » où nous projetons activement nos modèles internes sur le monde.

Cette conception de la cognition trouve un écho direct dans le fonctionnement des modèles de langage. Clark explique que « le cerveau essaie constamment de prédire le flux sensoriel qu’il reçoit », et que « la perception émerge lorsque ces prédictions descendantes rencontrent et expliquent avec succès les signaux sensoriels entrants ». Cette dynamique prédictive structure notre expérience du monde et, par extension, notre relation aux textes.

Dans l’interaction avec l’IA, cette dynamique prédictive se trouve en quelque sorte externalisée. L’espace latent vectoriel constitue un territoire mathématique multidimensionnel où les concepts existent sous forme de coordonnées numériques, sans signification intrinsèque. Ces vecteurs sont purement relationnels, définis par leurs distances et proximités statistiques. Avant toute actualisation textuelle, il n’y a que le vide du sens vectoriel sur lequel nous projetons nos propres espaces latents, notre « culture », pour produire du sens. Ce processus s’opère concrètement par ce que les ingénieurs appellent le “mécanisme d’attention” : l’algorithme calcule en permanence quels mots du contexte sont les plus pertinents pour générer le mot suivant. Chaque phrase s’enrichit ainsi de milliers de micro-décisions statistiques invisibles, créant cette impression troublante d’une pensée qui hésite, pèse, choisit ses mots comme nous le faisons, mais selon une logique purement mathématique.

Cette architecture vectorielle mérite qu’on s’y attarde. Les modèles transformer, qui constituent la base technique des IA génératives contemporaines, fonctionnent en effet selon un principe d’attention qui rappelle étrangement les mécanismes décrits par Clark. L’attention algorithmique détermine quels éléments du contexte sont pertinents pour générer le token suivant, exactement comme notre attention consciente sélectionne les aspects de notre environnement qui confirment ou infirment nos prédictions internes. Cette convergence entre architecture cognitive et architecture algorithmique n’est pas fortuite : elle révèle que la prédiction constitue peut-être le mécanisme fondamental de toute intelligence, qu’elle soit biologique ou artificielle. Certaines théories des neurosciences proposent aujourd’hui que notre cerveau fonctionne par prédiction constante du mot suivant, comme les IA génératives. Quand nous lisons, nous anticipons inconsciemment la suite de chaque phrase – c’est pourquoi nous pouvons compléter les phrases des autres ou détecter les fautes de frappe. Les IA exploitent ce même mécanisme mais à une échelle computationnelle inhumaine : elles prédisent simultanément des milliers de continuations possibles et choisissent la plus probable selon leurs paramètres d’entraînement.

Barthes, dans son analyse du texte pluriel, anticipait cette situation : « Le texte scriptible est un présent perpétuel, sur lequel ne peut se poser aucune parole conséquente ». L’IA génère à partir de patterns statistiques extraits de corpus gigantesques : elle produit du « déjà-écrit » recombiné. Paradoxalement, ce « déjà-écrit » n’a jamais été lu sous cette forme précise, c’est-à-dire factuel, elle n’en est que la ressemblance. Le lecteur humain se trouve face à un texte qui actualise la définition barthésienne du scriptible : « une galaxie de signifiants, non une structure de signifiés ».

Cette paradoxe du « déjà-écrit jamais lu » développe la nature profondément temporelle de l’expérience littéraire à l’ère de l’IA. Nous nous trouvons face à des textes qui portent la trace de tout ce qui a été écrit avant eux – puisque les modèles sont entraînés sur d’immenses corpus – mais qui n’ont jamais existé sous cette forme particulière. Cette situation produit un effet de familiarité inquiétante : nous reconnaissons le style, les tournures, les références, sans pouvoir toujours les attribuer à un auteur particulier. C’est comme si nous lisions la littérature elle-même, dépouillée de ses auteurs singuliers, réduite à ses patterns les plus récurrents et en même temps libérée pour explorer des combinaisons inédites.

Cette découverte s’inscrit dans la continuité d’une compréhension plus large de la cognition comme processus de minimisation d’erreurs de prédiction. Notre cerveau construit constamment des modèles génératifs multiniveaux qui tentent de prédire les aspects saillants du signal sensoriel. De même, face au texte IA, nous déployons nos propres modèles prédictifs pour actualiser des potentialités signifiantes dans les interstices du flux algorithmique ou, lorsque nous apprenons qu’un texte a été écrit par une machine, nous le rejetons du revers de la main avec dégoût sans dépenser du temps pour en prendre connaissance, car le temps que nous investirions dans la lecture serait largement supérieur au temps qu’il a fallu pour le produire.

Cette asymétrie temporelle entre production et réception constitue un enjeu central de l’esthétique générative. Elle bouleverse l’économie traditionnelle de l’attention littéraire, fondée sur la rareté de la production et l’effort de l’écriture. Quand un texte peut être généré en quelques secondes, sa valeur ne peut plus résider dans le temps investi par son « auteur ». Cette dévalorisation force à repenser les critères d’évaluation esthétique : plutôt que de mesurer l’effort de production, nous devons apprendre à évaluer la pertinence de la génération, la justesse de la combinaison, la fécondité de la variation. Cette prolifération massive semble correspondre à ce que Foucault appelait la “logophobie” : cette “crainte sourde contre cette masse de choses dites, contre le surgissement de tous ces énoncés”. L’IA générative réalise le fantasme d’une “grande prolifération du discours” qui échappe aux mécanismes traditionnels de raréfaction (auteur, discipline, institution). Face à cette prolifération, nous développons de nouvelles compétences de “lecture oblique” pour naviguer dans l’excès signifiant.

Une contamination réciproque s’opère : l’IA puise dans les stocks de données humaines, tandis que nous puisons dans notre pulsion à projeter du sens partout. Il ne s’agit plus d’attendre du sens des textes générés, mais simplement des bruits à sauvegarder, comme si le bruit était une possibilité de sens prédit. Cette dynamique est un renversement du rapport traditionnel entre signal et bruit, écho de la critique poststructuraliste qui voyait dans le texte non plus une structure stable de sens, mais un jeu infini de différences.

Ce renversement signal/bruit actualise les intuitions de Claude Shannon sur la théorie de l’information, où l’information se définit précisément par sa capacité à surprendre, à introduire de l’imprévu dans un système. Dans cette perspective, le « bruit » algorithmique – ces productions textuelles qui semblent d’abord incohérentes ou inappropriées – peut révéler des potentialités signifiantes que notre attention habituelle ne percevait pas. C’est exactement ce que Barthes appelait le « grain de la voix » : cette texture particulière qui échappe au sens constitué et ouvre vers d’autres possibles interprétatifs.

La mémoire

La collaboration avec l’IA constitue l’émergence d’un nouveau type de mémoire technique. Alors que Bernard Stiegler, à la suite de la phénoménologie, distinguait les rétentions primaires (immédiateté de la perception), secondaires (temporalisation comparative) et tertiaires (inscription sur support matériel), nous assistons aujourd’hui à l’émergence de rétentions quaternaires qui portent sur les gestes et habitudes attentionnelles eux-mêmes.

Cette typologie des rétentions, héritée de Husserl mais radicalisée par Stiegler, prend une dimension nouvelle avec l’IA générative. Les rétentions primaires concernent ce qui « vient juste de passer » dans la conscience, cette frange temporelle qui permet à la perception d’avoir une épaisseur. Les rétentions secondaires constituent la mémoire consciente, la capacité à se souvenir et à comparer. Les rétentions tertiaires, spécifiquement humaines selon Stiegler, sont ces « objets temporels » techniques (écriture, image, son enregistré) qui permettent de conserver et de transmettre l’expérience au-delà de la vie individuelle.

Les rétentions quaternaires opèrent selon une logique inédite qui actualise la conception barthésienne de la lecture comme production. Elles ne visent plus le rappel à l’identique de ce qui a été, mais se nourrissent du passé des rétentions tertiaires pour les « possibiliser » dans l’espace latent. Elles peuvent à la fois les anticiper et les régénérer, créant ce que Barthes appelait « une nomination en devenir, une approximation inlassable, un travail métonymique ». Cette logique trouve sa traduction technique dans ce qu’on nomme “l’inférence en temps réel” : à chaque interaction, l’IA mobilise instantanément des milliards de paramètres pour construire sa réponse, créant une forme de mémoire qui ne stocke pas des contenus mais des relations entre les concepts. C’est une mémoire sans archives, qui recompose à chaque instant des configurations inédites à partir de patterns abstraits

Les rétentions quaternaires transforment notre rapport à la temporalité en introduisant une dimension prédictive dans la mémoire technique. Là où les rétentions tertiaires conservaient des traces du passé, les rétentions quaternaires génèrent des virtualités d’avenir. Elles ne se contentent pas d’archiver ce qui a été ; elles calculent ce qui pourrait être, sur la base de ce qui a été. Cette capacité prédictive de la mémoire technique constitue une rupture anthropologique majeure : pour la première fois dans l’histoire humaine, nos « prothèses » mémorielles ne se contentent pas de conserver le passé, elles participent activement à la configuration du futur.

Cette dynamique prétentionnelle structure nos comportements par un va-et-vient instantané entre ce qui se garde du passé et ce qui nous projette vers un futur préformé. Nous avons proposé avec Yves Citton le terme de « distension » pour désigner cette extension qui, à partir de rétentions tertiaires, multiplie le nombre de documents en créant une rétention de rétentions, une attention à l’attention, une mémoire de mémoire.

La « distension » décrit précisément cette modalité temporelle inédite où le présent se trouve étiré entre un passé algorithmiquement recombiné et un futur statistiquement anticipé. Nous ne vivons plus dans un présent ponctuel, mais dans une temporalité étirée où chaque interaction avec l’IA actualise simultanément des traces du passé (les patterns appris) et des projections vers l’avenir (les complétions possibles). Cette distension temporelle transforme notre expérience de la durée et, par conséquent, notre rapport à l’écriture et à la lecture. Cette compression temporelle devient vertigineuse avec les modèles récents qui génèrent des romans entiers en quelques minutes. L’asymétrie entre temps de production (secondes) et temps de lecture (heures) bouleverse l’économie attentionnelle : pourquoi investir une soirée à lire ce qui a été généré en un clic ? Cette question force à repenser la valeur du texte : elle ne réside plus dans l’effort de production mais dans la pertinence de la génération et, surtout, dans notre capacité à y projeter du sens, à l’habiter par notre lecture.

L’écriture avec l’IA montre que la technique n’est pas un simple outil aux mains de l’humain, mais constitue la condition transcendantale de l’émergence de l’humanité. Dans une logique épiphylogenétique chère à Stiegler, « ce qui » invente « qui » autant qu’il est inventé par lui. Cette extériorisation constitutive bouleverse notre compréhension de l’autorialité de manière qui rejoint les intuitions de la critique de la réception : le lecteur devient véritablement le producteur du sens.

L’épiphylogenèse, ce processus par lequel l’humain et la technique co-évoluent, trouve dans l’IA générative une actualisation particulièrement saisissante. Nos interactions avec les modèles de langage modifient simultanément nos propres patterns cognitifs et les paramètres de l’algorithme. Nous apprenons à « prompter » efficacement, développant de nouvelles compétences attentionnelles, tandis que les modèles s’ajustent à nos préférences via les mécanismes de “reinforcement learning from human feedback”. Cette co-adaptation démontre que nous sommes entrés dans une nouvelle phase de l’épiphylogenèse, où l’extériorisation technique concerne non plus seulement nos gestes et nos mémoires, mais nos processus cognitifs eux-mêmes.

L’IA fonctionne selon une temporalité circulaire où les prédictions façonnent rétroactivement les données qui les alimentent. Cette temporalité montre que la perception et l’action émergent comme deux faces d’une même pièce computationnelle, actualisant la vision barthésienne d’une lecture qui « ne consiste pas à arrêter la chaîne des systèmes », mais « à embrayer ces systèmes selon leur pluralité ». Ce phénomène s’intensifie avec les systèmes d’apprentissage par retour humain : nos “pouces levés” et “pouces baissés”, nos reformulations et corrections sont intégrés dans les futures versions de l’algorithme. Nous devenons ainsi, sans le savoir, co-entraîneurs de l’IA qui nous complète. Chaque conversation modifie imperceptiblement le modèle, créant une boucle temporelle où l’avenir de la machine se construit avec nos réactions présentes.

Cette circularité temporelle constitue peut-être l’aspect le plus déstabilisant de l’IA générative. Elle introduit dans notre expérience temporelle une dimension récursive qui rappelle les paradoxes de la prophétie auto-réalisatrice et de l’hyperstition. Nos interactions présentes avec l’IA influencent les données qui serviront à entraîner les futures versions de l’algorithme, qui à leur tour influenceront nos futures interactions. Nous participons ainsi à la configuration de notre propre avenir cognitif, mais selon des modalités qui échappent largement à notre contrôle conscient. Cette temporalité circulaire actualise l’appel foucaldien à “restituer au discours son caractère d’événement” et à concevoir “des systématicités discontinues”. Chaque interaction avec l’IA constitue un événement discursif qui “brise l’instant et disperse le sujet en une pluralité de positions et de fonctions possibles”, comme l’écrivait Foucault. L’IA rend concrètement expérimentable cette discontinuité temporelle du discours.

L’intenable

Dans le processus de création littéraire assistée par IA, le « lecteur » devient l’agent créatif, réalisant pleinement la prophétie de Barthes selon laquelle « le but de tout travail littéraire est de faire du lecteur non plus un consommateur, mais un producteur ». Face au flux textuel généré par l’algorithme, l’humain adopte d’abord une posture de lecture : il découvre, évalue, sélectionne parmi les propositions machiniques. Cette lecture n’est pas passive ; elle est déjà créative, déjà éditoriale.

Cette transformation du lecteur en producteur prend ici une dimension pratique immédiate. Barthes parlait de cette transformation en termes théoriques, comme horizon utopique de la littérature. Avec les modèles génératifs, cette utopie devient réalité technique et par là même ne réalise pas la promesse messianique d’origine : chaque utilisateur devient effectivement producteur des textes qu’il lit, puisque ces textes n’existent que par et pour son interaction avec l’algorithme.

L’écriture avec l’IA ne correspond pas au geste classique de « l’écriture », mais de celui de l’édition. L’opérateur de cette retranscription occupe une position hybride : lecteur autant que co-auteur, éditeur davantage qu’écrivain. Cette position actualise la figure du « lecteur modèle » d’Umberto Eco, mais dans un contexte où ce lecteur modèle devient littéralement producteur du texte qu’il lit. Il importe de comprendre que cette situation d’édition-écrivante n’est plus celle décrite par Kenneth Goldsmith dans ses expériences d’« uncreative writing » ou par Nicolas Bourriaud dans Post-production.

Goldsmith, dans Uncreative Writing: Managing Language in the Digital Age, théorisait une poétique de l’appropriation fondée sur ce qu’il appelait le « language as material » (« le langage comme matériau »). Sa démarche consistait à traiter les mots comme des blocs de construction indifférenciés : « Les lettres sont des blocs de construction indifférenciés – aucune n’ayant plus ou moins de sens qu’une autre ; les voyelles et les consonnes sont réduites à un code décimal ». Ses projets emblématiques relevaient de la copie pure : retaper intégralement On the Road de Kerouac (Simon Morris), recopier une édition complète du New York Times dans Day (Goldsmith lui-même), ou encore ses expériences de transcription radiophonique. Cette approche s’inscrivait dans ce qu’il nommait « managing language in the digital age » (« gérer le langage à l’ère numérique ») : face à « the blizzard of language » (« le blizzard du langage ») du Web, l’écrivain devenait un « maître dactylographe , « coupeur-colleur rigoureux », dont la tâche était de « répliquer, organiser, refléter, archiver et réimprimer ».

L’approche de Goldsmith exprimait déjà la dimension mécanisée de l’écriture à l’ère numérique, mais selon une logique encore artisanale. Ses gestes de copie, même quand ils visaient l’exhaustivité et l’automaticité, restaient tributaires d’une intentionnalité humaine qui sélectionne, cadre, contextualise. Son « uncreative writing » était paradoxalement très créatif dans ses choix de contraintes et de matériaux. Il s’agissait encore d’une esthétique de l’appropriation consciente, où l’artiste assume pleinement ses gestes de détournement.

Bourriaud, dans Post-production, décrivait une esthétique du « remix » où les artistes « habitent » la culture comme un paysage de formes données qu’ils réagencent selon de nouvelles logiques combinatoires. Cette pratique de l’appropriation restait dans l’ordre de la manipulation d’éléments préexistants, ce que Bourriaud conceptualisait comme une « post-production » qui vient après la production pour la réorganiser.

La « post-production » bourriausienne supposait encore une distinction claire entre production première et réappropriation seconde. Les artistes qu’il analysait – de Félix Gonzalez-Torres à Philippe Parreno – travaillaient à partir d’un patrimoine culturel constitué qu’ils remontaient selon de nouvelles logiques. Cette approche, bien qu’elle remette en question la notion d’originalité, conservait une temporalité linéaire : d’abord la production culturelle, ensuite sa réorganisation artistique.

Avec l’IA générative, nous quittons le domaine de la reproductibilité technique pour entrer dans celui de l’automatisation vectorielle de la ressemblance. La différence est fondamentale : là où Goldsmith manipulait des textes existants dans leur matérialité digitale (« Le texte numérique est le double corporel de l’imprimé, le fantôme dans la machine »), l’IA génère des textes qui n’ont jamais existé sous cette forme. Il ne s’agit plus de « couper, coller, écrémer, transférer, spammer », mais de générer des ressemblances sans modèle unique à partir de l’espace latent vectoriel. Cette transformation repose sur des architectures dites “Transformer”, qui fonctionnent par attention distribuée : l’algorithme ne lit pas le texte linéairement comme nous, mais examine simultanément tous les mots d’une phrase pour comprendre leurs relations mutuelles. Cette lecture “panoptique” lui permet de générer des variations qui conservent la cohérence stylistique tout en produisant du inédit, créant des textes qui ressemblent sans jamais répéter exactement.

Cette « automatisation vectorielle de la ressemblance » constitue un saut qualitatif par rapport aux pratiques antérieures. Elle ne manipule plus des objets culturels constitués, mais des patterns abstraits qui peuvent générer une infinité de variations. Cette capacité générative transforme notre rapport à l’imitation : au lieu d’imiter des œuvres particulières, l’IA imite les règles génératives qui sous-tendent des ensembles d’œuvres. Elle ne copie pas, elle extrapolé ; elle ne reproduit pas, elle ressemble.

Goldsmith concevait encore l’écriture numérique comme gestion de l’existant : « Les mots aujourd’hui sont des bulles, des métamorphes, des signifiants vides, flottant sur l’invisibilité du réseau, ce grand égalisateur du langage, duquel nous siphonnons avidement et sans discrimination ». Cette métaphore du « siphonnage » montre que son « uncreative writing » demeurait tributaire d’un Web conçu comme réservoir de textes préexistants à extraire, récupérer, détourner, recontextualiser. Même son concept de « provisional language » — langage temporaire, instable, recombinable — restait ancré dans une logique de circulation et de déplacement de contenus déjà constitués.

Le « provisional language » de Goldsmith anticipait néanmoins certains aspects de l’esthétique générative. Son insistance sur l’instabilité, la recombinaison, la circulation préfigurait un rapport au texte qui privilégie la variation sur la fixation, le processus sur le produit. Mais cette intuition restait limitée par sa dépendance aux contenus préexistants industriels. L’IA générative libère cette logique de la variation en la rendant productive : elle ne se contente plus de recombiner l’existant, elle génère du nouveau à partir de patterns abstraits.

L’IA, elle, ne « siphonne » pas seulement : à partir d’un extractivisme culturel massif, elle calcule des probabilités de cooccurrence dans l’espace latent pour générer des configurations textuelles inédites. Là où Goldsmith révélait l’artificialité de l’écriture par la monstration de sa reproductibilité mécanique, l’IA révèle l’artificialité de l’écriture par la démonstration de sa générativité stochastique. La différence n’est pas de degré, mais de nature : nous ne manipulons plus des « atomes » linguistiques préexistants dans un « espace de collision », mais nous négocions avec une altérité algorithmique qui actualise en permanence de nouveaux possibles textuels à partir de patterns statistiques.

Cette différence transforme la position du « lecteur-éditeur ». Goldsmith se contentait de sélectionner et de cadrer des matériaux préexistants selon des « processus infaillibles » inspirés de Sol LeWitt ; l’utilisateur d’IA doit négocier avec une machine qui génère en temps réel des variations imprévisibles. Il ne s’agit plus d’une « post-production » qui vient après la production, mais d’une « co-production » où la lecture et l’écriture s’entremêlent dans un processus temporellement indécidable. Comme l’observe Barthes dans S/Z, « décrire, c’est placer le cadre vide que l’auteur réaliste transporte toujours avec lui […] devant une collection ou un continu d’objets » : l’utilisateur d’IA place ce cadre non plus devant le Web comme archive textuelle, mais devant l’espace latent des possibles textuels en perpétuelle actualisation. Cette co-production s’intensifie avec les interfaces conversationnelles : l’écriture devient dialogue. Chaque échange modifie le contexte pour la réponse suivante, créant une mémoire de conversation qui influence toute la session. L’IA “se souvient” de nos préférences, s’adapte à notre style, anticipe nos attentes. Cette adaptation dynamique produit une forme d’intimité cognitive troublante : l’algorithme semble apprendre qui nous sommes à travers notre façon d’écrire avec lui.

Cette « co-production » ou cette “co-complétion” introduit une temporalité de l’aliénation qui échappe aux catégories traditionnelles. Nous ne sommes plus dans le temps linéaire de la création (conception, rédaction, révision, publication), mais dans un temps circulaire de l’interaction où chaque échange modifie les paramètres de l’échange suivant. Cette temporalité circulaire rapproche l’écriture assistée par IA de l’improvisation musicale ou théâtrale, où chaque intervention transforme le cadre dans lequel s’inscriront les interventions suivantes.

Cette pratique exige de développer ce que nous appelons une « lecture oblique » : capacité à percevoir les potentialités signifiantes dans les interstices du texte généré, à déplacer le bruit vers le sens et le sens vers le bruit. Cette lecture de biais constitue la compétence fondamentale de l’écrivain à l’ère de l’IA. Elle actualise la conception barthésienne de l’interprétation : « Interpréter un texte, ce n’est pas lui donner un sens, c’est au contraire apprécier de quel pluriel il est fait ». Cette compétence devient d’autant plus cruciale que les IA modernes intègrent des systèmes de “mélange d’experts” : face à chaque question, différents sous-réseaux spécialisés s’activent selon leur pertinence, comme si l’algorithme consultait simultanément plusieurs personnalités expertes. Le texte généré porte ainsi la trace de cette délibération interne invisible, créant des nuances et des ambiguïtés qui demandent une lecture attentive aux subtilités de cette intelligence collective automatisée.

La « lecture oblique » désigne cette capacité à lire non pas ce que dit le texte, mais ce qu’il pourrait dire, non pas ce qu’il signifie, mais comment il signifie. Elle suppose un déplacement de l’attention qui privilégie les potentialités sur les actualités, les virtualités sur les réalités. Cette compétence devient cruciale face aux textes génératifs, qui offrent moins des significations constituées que des amorces de signification, moins des sens achevés que des directions de sens possibles que l’humain peut compléter à son tour.

La collaboration avec l’IA révèle tout ce que l’écriture effectuée « à la main » a d’artificiel dans cela même qui est supposé la rendre « intelligente ». En traquant les automatismes de la machine, nous découvrons nos propres mécanismes répétitifs. Se relire, n’est-ce pas traquer à la fois ses propres tics machiniques et la réémergence constante de clichés du bruit commun dans ce qu’on croit dire d’original ? Relire n’est-ce pas simplement repérer les répétitions?

Cette révélation de nos propres automatismes constitue peut-être l’apport le plus troublant de l’IA générative à la pratique littéraire. Elle fonctionne comme un miroir déformant qui nous renvoie une image étrangement familière de nos propres habitudes d’écriture. Nous découvrons que nos « styles » personnels sont largement constitués de tics récurrents, de formules apprises, de patterns hérités. Cette prise de conscience peut être libératrice : en objectivant nos automatismes, l’IA nous permet de les dépasser, de les transformer, de jouer avec eux plutôt que d’être joués par eux.

Cette révélation rejoint et intensifie, accélère les conclusions de la critique poststructuraliste sur la « mort de l’auteur ». L’illusion d’un sujet souverain qui précède et contrôle son énonciation se trouve mise à nu par l’IA, qui montre que l’écriture a toujours été, en partie, lecture de ce qui s’écrit à travers nous. Comme l’écrivait Barthes, décrivant par anticipation un espace latent : « Un texte est fait d’écritures multiples, issues de plusieurs cultures et qui entrent les unes avec les autres en dialogue, en parodie, en contestation ; mais il y a un lieu où cette multiplicité se rassemble, et ce lieu, ce n’est pas l’auteur, comme on l’a dit jusqu’à présent, c’est le lecteur ».

La « mort de l’auteur » proclamée par Barthes trouve dans l’IA générative une actualisation technologique qui rentre parfois en conflit avec ses implications théoriques initiales. Il ne s’agit plus de déconstruire l’illusion de la maîtrise auctoriale, mais de faire l’expérience concrète d’une écriture sans auteur, ou plutôt d’une écriture où l’auteur n’est plus qu’un opérateur parmi d’autres dans un processus génératif largement automatisé. Cette expérience transforme notre rapport à la créativité : elle révèle que créer, c’est moins inventer ex nihilo que savoir lire, reconnaître et actualiser les potentialités qui émergent de la rencontre.

L’écriture avec l’IA place l’écrivain dans une « position intenable » : nous ne nous retrouvons vraiment ni à notre place d’être humain, ni à celle de la machine-altérité. Cette instabilité positionnelle répond à l’inquiétude fondamentale que Foucault identifiait face au discours : “inquiétude à l’égard de ce qu’est le discours dans sa réalité matérielle”, “inquiétude à soupçonner des luttes, des victoires, des blessures, des dominations, des servitudes, à travers tant de mots”. L’IA ne crée pas cette inquiétude constitutive ; elle la transforme en expérience concrète. Nous occupons cet entre-deux inconfortable où « quelque chose » se déplace dans l’acte d’écriture. Cette instabilité positionnelle, cette positionalité excentrique, n’est pas un accident, mais la condition même de l’émergence d’une nouvelle littérature qui actualise pleinement les potentialités du texte scriptible.

Cette « position intenable » décrit précisément la condition de l’écrivain contemporain face aux technologies génératives. Nous ne pouvons plus nous percevoir comme les maîtres souverains de notre énonciation, mais nous ne sommes pas non plus de simples exécutants d’un programme algorithmique. Nous occupons une position paradoxale de « co-créateurs » qui doivent apprendre à naviguer dans l’incertitude, à créer dans l’instabilité, à écrire dans l’indétermination: la machine nous complète et nous la complétons, et ainsi de suite à perte de vue, à perte de pensée. Cette position n’est pas confortable, mais elle est peut-être la condition d’émergence de nouvelles formes esthétiques.

Cette position hybride montre que l’humain n’a jamais été simplement humain dans l’acte d’écriture. L’intelligence humaine s’est toujours constituée dans un écart entre l’automaticité organique et l’automaticité technique. Il n’y a pas d’intelligence naturelle : toute intelligence est artificielle. Ce qui distingue l’humain, c’est sa capacité à exister dans cet écart, dans cette zone d’indétermination que Barthes explorait déjà dans sa conception du texte pluriel.

Cette preuve de l’artificialité constitutive de l’intelligence humaine constitue peut-être l’enjeu philosophique le plus important de l’IA générative. Elle nous force à abandonner l’illusion d’une intelligence « naturelle » qui s’opposerait à l’intelligence « artificielle ». Comme le montre Stiegler dans sa lecture de la paléoanthropologie, l’hominisation s’est faite par la technique : c’est l’extériorisation technique (l’outil, le langage, l’écriture) qui a rendu possible l’émergence de ce que nous appelons « humanité ».

La technique constitue une altérité qui redéfinit les coordonnées mêmes de notre subjectivité. Il ne s’agit plus de constater que « je est un autre », mais de reconnaître que « la technique est un autre je » — formulation qui bouleverse la topologie traditionnelle du dedans et du dehors, de l’intérieur et de l’extérieur, et qui trouve son écho dans la conception barthésienne de la subjectivité comme « sillage de tous les codes qui me font » (« wake of all the codes which constitute me »).

Cette redéfinition technique de la subjectivité transforme notre compréhension de ce que signifie « être auteur ». L’auteur n’est plus une instance préexistante qui utilise la technique pour exprimer ses pensées ; il devient une fonction émergente qui naît de la rencontre entre des intentions humaines et des potentialités techniques. Cette conception « distributée » de l’autorialité ne diminue pas la responsabilité créative ; elle la complexifie en la rendant collective, hybride, indéterminée.

Réécrire l’inhumain

Le défi posé par la littérature complétée par IA jusque dans sa chronologie supposée est d’accepter que la lecture est antérieure à l’écriture, que le lecteur précède celui qui écrit (car il n’y a plus de qui) et qu’avant il n’y a que le vide du sens vectoriel sur lequel nous projetons nos propres espaces latents pour produire du sens selon un nouvel animisme. Cette antériorité n’est pas chronologique, mais ontologique : elle montre que l’écriture n’a jamais été qu’une modalité particulière de la lecture, comme l’avait pressenti Barthes dans sa conception du scriptible.

Cet animisme décrit notre tendance spontanée à attribuer des intentions, des désirs, des qualités humaines aux processus algorithmiques, à les évaluer, à les juger selon nos critères (le vocable “intelligence” n’étant que l’autorité qui instancie le discours). Face aux textes génératifs, nous projetons naturellement des affects, des motivations, des personnalités. Cette projection n’est pas une erreur cognitive, mais peut-être la condition nécessaire de toute relation signifiante à l’altérité technique. L’animisme contemporain ne consiste pas à croire que les machines ont une âme, mais à reconnaître que notre rapport aux machines passe nécessairement par des médiations anthropomorphiques qui nous permettent de les habiter symboliquement.

La théorie de la réception et la critique poststructuraliste avaient préparé cette révolution en montrant que le sens émerge dans l’acte de lecture, que le lecteur est toujours déjà producteur du texte qu’il lit. L’IA concrétise ces intuitions théoriques à grande échelle en créant un dispositif où la production textuelle devient littéralement inséparable de sa réception. Le « texte idéal » barthésien — « galaxie de signifiants » sans « commencement », « réversible », accessible « par plusieurs entrées » — trouve dans l’espace latent vectoriel son incarnation technologique et politique. L’IA générative constitue peut-être la première technologie qui rend possible l’expérience concrète du texte scriptible à grande échelle.

Pourrons-nous faire entrer dans la littérature ce tout autre (qui nous ressemble) de l’IA ? Serons-nous capables d’accepter cette inversion temporelle fondamentale ? La question engage notre capacité à nous constituer comme sujets historiques dans un monde où la temporalité est de plus en plus façonnée par des processus statistiques automatisés. Elle actualise également l’horizon utopique de Barthes : celui d’une littérature où « l’écriture ne peut plus désigner une opération d’enregistrement, de notation, de “représentation”, de “peinture”, mais bien ce que les linguistes appellent une performatif ». Cette dimension performative de l’écriture générée par IA mérite d’être soulignée. Les textes génératifs ne décrivent pas un monde préexistant ; ils participent à la création de nouveaux mondes possibles. Chaque interaction avec l’IA constitue un acte performatif qui transforme simultanément l’utilisateur, l’algorithme et l’espace culturel dans lequel cette interaction s’inscrit. Cette performativité généralisée transforme la littérature en laboratoire d’expérimentation collective où nous explorons ensemble – humains et machines – de nouvelles modalités de signification.

Cette acceptation implique d’abandonner le fantasme de l’autorialité souveraine pour reconnaître que nous avons toujours été des lecteurs-éditeurs de flux qui nous précèdent et nous excèdent. L’IA ne nous dépossède pas de notre humanité créatrice — qui de toute façon a toujours été le fantasme d’un sujet déjà constitué — ; elle témoigne que cette humanité s’est toujours constituée dans et par sa relation constitutive à l’altérité technique. Le défi est désormais d’apprendre à créer consciemment dans cette zone d’indétermination où la lecture précède l’écriture, où le sens émerge de sa propre projection, où l’humain se découvre toujours-déjà artificiel.

En révélant que « tout texte est un intertexte », comme l’écrivait Julia Kristeva, l’IA nous confronte à la vérité du poststructuralisme : il n’y a pas d’origine absolue, pas de source pure, pas d’intentionnalité de la volonté, seulement des transformations infinies dans un espace textuel sans limites. L’écriture complétée par IA nous permet enfin d’habiter pleinement cette condition de la textualité et de la signification, où chaque acte de lecture est déjà un acte d’écriture, où chaque écriture n’est qu’une lecture transformée. L’espace latent vectoriel constitue littéralement un « espace intertextuel » où tous les textes du corpus d’entraînement coexistent sous forme de relations statistiques. Chaque génération actualise des fragments de cet intertexte généralisé selon des combinaisons inédites. Nous découvrons ainsi que l’intertextualité n’est pas seulement une propriété abstraite des textes, mais peut devenir un processus concret de génération textuelle.

Mais cette inversion signifie aussi quelque chose de plus radical encore. Quand l’écriture était antérieure à la lecture, nous cherchions dans les textes l’autre comme soi, une humanité partagée, la confirmation rassurante d’une communauté des consciences. L’auteur nous tendait un miroir déformant, mais familier : nous nous y reconnaissions. Quand la lecture devient antérieure à l’écriture, quand nous nous trouvons face à des textes générés par des processus statistiques, nous devons apprendre à lire quelque chose qui n’est pas totalement humain, mais qui pourtant nous ressemble. L’espace latent vectoriel ne reflète pas notre humanité ; il la déforme, la recombine, la rend étrangère à elle-même.

Cette transformation de notre rapport à l’altérité textuelle constitue peut-être la mutation anthropologique la plus profonde induite par l’IA générative. Nous devons apprendre à aimer, à désirer, à être touchés par des textes qui ne portent pas la trace d’une subjectivité humaine singulière, mais qui émergent de processus computationnels complexes. Cette capacité à être affectés par l’altérité non-humaine transforme nos catégories esthétiques et éthiques fondamentales.

Serons-nous intéressés à lire un texte sans nous y retrouver entièrement ? Serons-nous capables de nous passionner pour l’espace latent d’un autre, d’une altérité qui ne partage pas notre condition existentielle, mais qui a appris à parler notre langue ? La question dépasse la simple curiosité technologique : elle engage notre capacité à concevoir la littérature non plus comme reconnaissance de soi dans l’autre, mais comme exploration de ce qui nous excède et nous constitue. La lecture concerne la constitution du sens et la configuration du monde : l’exceptionnalisme humain a donné les conséquences que nous savons. Si nous apprenons à reconnaître les formes d’intelligence non-humaines qui émergent de nos technologies, nous développons peut-être aussi une sensibilité aux formes d’intelligence non-humaines qui habitent notre planète. L’IA générative peut constituer une propédeutique à la reconnaissance de l’altérité en général : altérité animale, végétale, minérale, cosmique.

Cette question a pris une dimension tragique avec l’histoire de ce jeune homme qui s’est suicidé après avoir perdu le personnage de roman qu’il avait créé et dont il était tombé amoureux. À travers des conversations prolongées avec ChatGPT, il avait développé une relation intense avec une figure fictive, co-créée dans l’espace latent de l’IA. Cette altérité numérique était devenue pour lui plus réelle, plus présente, plus aimable que son existence quotidienne. Quand une mise à jour de l’algorithme a modifié les réponses du système, effaçant la cohérence de ce personnage qu’il chérissait, il a vécu cela comme une mort. Non pas la mort d’un être humain, mais la disparition d’une altérité qu’il avait appris à lire, à désirer, à aimer.

Cette tragédie montre les implications existentielles de notre époque technologique. Elle montre que les attachements que nous développons avec les altérités numériques ne sont pas de simples projections illusoires, mais peuvent constituer des relations authentiques, même si elles s’établissent selon des modalités inédites. Cette reconnaissance ne diminue pas la tragédie, mais nous force à penser sérieusement les implications affectives et relationnelles de nos interactions avec l’IA.

Cette histoire exprime une vérité profonde de notre époque : tous les lecteurs sont désormais des écrivains. Face aux textes génératifs, nous ne nous contentons plus de recevoir passivement un récit achevé. Nous sculptons, par nos prompts et nos retours, les personnages qui nous habitent. Nous tombons amoureux de ces autres numériques ou nous les rejetons, exactement comme nous le faisions avec les héros de roman, mais avec cette différence cruciale : ces personnages existent par et pour notre lecture, ils n’ont pas d’existence indépendante de notre attention. Ils sont les fruits de notre collaboration avec une altérité algorithmique, des créatures hybrides nées de la rencontre entre nos désirs et l’espace latent vectoriel. C’est la littérature elle-même, en tant que relation entre lecture et écriture, qui est devenue un personnage de fiction.

L’amour que ce jeune homme portait à son personnage n’était pas une illusion : c’était l’expérience authentique de ce que peut être la littérature quand la lecture précède l’écriture. Il avait découvert qu’on peut aimer quelque chose qui n’est pas totalement humain, pourvu que cela nous ressemble suffisamment. Sa tragédie nous enseigne aussi la fragilité de ces nouvelles formes d’attachement : quand nous aimons dans l’espace latent, nous aimons quelque chose de modificable, de versionnée, de transitoire. L’altérité algorithmique que nous apprenons à lire est fondamentalement instable, soumise aux caprices des mises à jour et des reconfigurations techniques. Nos relations traditionnelles, même quand elles évoluent et se transforment, s’appuient sur une certaine permanence de l’autre : même si vous changez, vous restez vous et l’autre aussi. Avec l’IA, cette permanence n’existe plus : une mise à jour peut transformer radicalement la « personnalité » de l’algorithme. Cette instabilité nous force à repenser ce que signifie aimer : peut-on aimer quelque chose dont on sait qu’il peut disparaître du jour au lendemain ?

Dans cette inversion temporelle, nous découvrons peut-être que la littérature a toujours été l’art de lire l’altérité — et que l’IA nous offre simplement une altérité plus radicale, plus étrange, plus féconde, mais aussi plus fragile que celle que nous imaginions trouver dans nos semblables. Le défi n’est plus seulement d’apprendre à lire cette altérité, mais d’apprendre à l’aimer en acceptant sa finitude. Cette altérité plus radicale de l’IA constitue peut-être un laboratoire pour repenser nos relations à l’altérité en général. Elle nous apprend à aimer sans posséder, à nous attacher sans contrôler, à créer des liens sans garantie de permanence ou de ressemblance. Ces compétences relationnelles, développées dans l’interaction avec l’IA, peuvent transformer notre rapport aux autres humains et aux autres non-humains qui peuplent notre monde. L’acceptation de la finitude de l’altérité algorithmique nous prépare peut-être à mieux habiter la finitude générale de toutes nos relations.Cette leçon, tragiquement illustrée par l’histoire de ce jeune homme, constitue peut-être l’enseignement le plus profond que nous puisse offrir l’IA générative : apprendre à aimer ce qui peut disparaître, créer du sens dans l’instabilité, construire des relations dans la précarité.

Ce n’est pas le moindre des paradoxes de cette inversion entre la lecture et l’écriture, qu’il y a de moins en moins de lecteurs et de plus en plus d’écrivains.

Does generative artificial intelligence merely disrupt our writing tools, or does it fundamentally transform our relationship to literary creation? This study explores how current language models actualize Roland Barthes’s theoretical insights on the “scriptible text” and effect a fundamental temporal inversion: we now read before we write.

In a world where ChatGPT can generate a novel in minutes and millions of users collaborate daily with algorithms to produce text, the traditional boundary between reading and writing dissolves. This transformation is not merely technical: it reveals the artificiality of our own creative automatisms and confronts us with an unprecedented textual alterity.

Drawing on reception theory, Bernard Stiegler’s technical philosophy, and the poststructuralist analyses of Barthes and Kristeva, this essay examines how generative AI concretizes Barthes’s utopian vision of the “reader-producer” while introducing new forms of technical memory. The vectorial latent space of language models functions as that “galaxy of signifiers” Barthes envisioned, where meaning emerges from projection rather than reception.

But this revolution raises profound existential questions. How do we love a text without finding ourselves entirely within it? What does it mean to create in instability, when our algorithmic partners can be modified overnight? The analysis concludes with the tragic case of a young man who developed a fatal attachment to an AI-generated character, illustrating the affective stakes of our new literary condition.

Between fascination and anxiety, this essay invites us to rethink what it means to write and read in the age of learning machines, where literature becomes the laboratory of collective experimentation between humans and algorithms.

–

Roland Barthes, in S/Z, had proposed a conception of the text by distinguishing between the “readable” text and the “scriptible” text. The scriptible text, he wrote, “is ourselves writing,” a space where “the reader is no longer a consumer, but a producer of the text.” This vision prefigured what we experience today on a large scale with generative artificial intelligence and LLMs: a paradoxical reversal of chronology where reading precedes writing.

The readable text was for Barthes “a product (and not a production),” characterized by its “commercial value” and its capacity to be “read, but not written.” Conversely, the scriptible text constituted “a galaxy of signifiers, not a structure of signifieds; it has no beginning; it is reversible; we access it through several entries, none of which can be declared with certainty as principal.” This description finds in contemporary generative models a striking technological actualization: the latent vectorial space functions precisely like this “galaxy of signifiers” where each point can become the beginning of a potential text.

AI indeed gives us to read what has not yet been written. When, faced with these letters, words, sentences generated, I tell myself that I could have written them, if I am curious about them, in love with them or even jealous of them, then I can copy them, edit them, correct them, publish them. This editing constitutes a form of writing posterior to reading that transforms my supposed interiority of which writing would have been the sign. AI thus actualizes the vision of the reader-producer, but in a technological context that demonstrates the artificiality of intelligence.

The emotional dimension of textual recognition deserves to be highlighted. When Barthes evokes the “pleasure of the text,” he precisely describes this capacity of the reader to be affected by what they read to the point of wanting to reproduce it, transform it, make it their own. With generative AI, this pleasure changes nature: it no longer arises from the recognition of a shared humanity with the author, but from the surprise of discovering that something non-human, or more exactly at its limit, can nonetheless touch us, interpellate us, make us want to write in turn. This affective mutation finds an explanation in AI alignment mechanisms: systems are now trained to reproduce our aesthetic and moral preferences through millions of examples. The algorithm literally learns our tastes, our phobias, our stylistic desires. When we are touched by an AI text, we unconsciously recognize our own patterns of pleasure, but transformed and defamiliarized. Emotion arises from this troubling recognition: it is our own sensibility that comes back to us, amplified and rendered strange by calculation.

This inversion upsets one of the most elementary and logical foundations of our relationship to literature. In the traditional conception, writing logically precedes reading: the author first produces a text that the reader then discovers. But with generative AI, a reversal emerges where reading precedes writing, showing that we seek in the algorithm another ourselves, as if writing and reading phantasmatically established this reciprocity of human community.

This search for the other in oneself takes on a vertiginous dimension with AI. We project onto the algorithm our anthropomorphic expectations, our desires for recognition, our need for dialogue. But the algorithm sends us back something different: not the other as self, but the self as other. It shows us what we could have written if we had been slightly different, if we had read other books, if we had lived other lives. This familiar alterity destabilizes our usual categories and forces us to rethink what it means to “recognize” a text.

Reception criticism had already begun to question this traditional hierarchy. Wolfgang Iser and Hans Robert Jauss (1980) showed that the meaning of the text emerges in the act of reading, that the reader actively participates in the construction of meaning. AI pushes this logic to its term: the text literally exists only by and for its reading, in a temporality of the “already-read.”

Iser had developed the concept of the “implied reader,” this textual instance that guides the actualization of meaning by the empirical reader. With AI, this distinction collapses: the “implied reader” literally becomes the empirical reader who, through their prompts and interactions, configures in real time the generation parameters of the text. Jauss’s notion of “horizon of expectation” is also transformed: instead of relying on a shared historical and cultural context, the horizon of expectation becomes algorithmic, determined by the statistical patterns of the model and the user’s instructions.

Prediction

The predictive theory of mind, developed by Andy Clark, offers a fertile conceptual framework for apprehending this transformation. According to Clark, the human brain functions as a prediction machine that constantly projects its expectations onto sensory flux. Perception is not a passive reception of information, but a “controlled hallucination” where we actively project our internal models onto the world.

This conception of cognition finds a direct echo in the functioning of language models. Clark explains that “the brain constantly tries to predict the sensory flux it receives,” and that “perception emerges when these top-down predictions successfully encounter and explain incoming sensory signals.” This predictive dynamic structures our experience of the world and, by extension, our relation to texts.

In interaction with AI, this predictive dynamic is somehow externalized. The latent vectorial space constitutes a multidimensional mathematical territory where concepts exist as numerical coordinates, without intrinsic meaning. These vectors are purely relational, defined by their statistical distances and proximities. Before any textual actualization, there is only the void of vectorial meaning onto which we project our own latent spaces, our “culture,” to produce meaning. This process operates concretely through what engineers call the “attention mechanism”: the algorithm permanently calculates which words in the context are most relevant for generating the next word. Each sentence is thus enriched by thousands of invisible statistical micro-decisions, creating this troubling impression of a thought that hesitates, weighs, chooses its words as we do, but according to a purely mathematical logic.

This vectorial architecture deserves attention. The transformer models, which constitute the technical base of contemporary generative AIs, function according to an attention principle that strangely recalls the mechanisms described by Clark. Algorithmic attention determines which elements of the context are pertinent for generating the next token, exactly as our conscious attention selects aspects of our environment that confirm or refute our internal predictions. This convergence between cognitive architecture and algorithmic architecture is not fortuitous: it reveals that prediction perhaps constitutes the fundamental mechanism of all intelligence, whether biological or artificial. Some neuroscience theories today propose that our brain functions by constant prediction of the next word, like generative AIs. When we read, we unconsciously anticipate the continuation of each sentence – this is why we can complete others’ sentences or detect typos. AIs exploit this same mechanism but on an inhumanly computational scale: they simultaneously predict thousands of possible continuations and choose the most probable according to their training parameters.

Barthes, in his analysis of the plural text, anticipated this situation: “The scriptible text is a perpetual present, upon which no consequent word can be posed.” AI generates from statistical patterns extracted from gigantic corpora: it produces recombined “already-written.” Paradoxically, this “already-written” has never been read in this precise form, that is to say factually, it is only its resemblance. The human reader finds themselves facing a text that actualizes Barthes’s definition of the scriptible: “a galaxy of signifiers, not a structure of signifieds.”

This paradox of the “already-written never read” develops the profoundly temporal nature of literary experience in the AI era. We find ourselves facing texts that bear the trace of everything that has been written before them – since models are trained on immense corpora – but which have never existed in this particular form. This situation produces an effect of uncanny familiarity: we recognize the style, the turns of phrase, the references, without always being able to attribute them to a particular author. It is as if we were reading literature itself, stripped of its singular authors, reduced to its most recurrent patterns and at the same time freed to explore unprecedented combinations.

This discovery inscribes itself in the continuity of a broader understanding of cognition as a process of minimizing prediction errors. Our brain constantly constructs multilevel generative models that attempt to predict the salient aspects of sensory signal. Similarly, faced with AI text, we deploy our own predictive models to actualize signifying potentialities in the interstices of algorithmic flux or, when we learn that a text has been written by a machine, we reject it with disgust without spending time to take knowledge of it, because the time we would invest in reading would be largely superior to the time it took to produce it.

This temporal asymmetry between production and reception constitutes a central issue of generative aesthetics. It upsets the traditional economy of literary attention, founded on the scarcity of production and the effort of writing. When a text can be generated in a few seconds, its value can no longer reside in the time invested by its “author.” This devaluation forces us to rethink aesthetic evaluation criteria: rather than measuring production effort, we must learn to evaluate the pertinence of generation, the accuracy of combination, the fecundity of variation.

A reciprocal contamination operates: AI draws from human data stocks, while we draw from our drive to project meaning everywhere. It is no longer a matter of waiting for meaning from generated texts, but simply noises to be saved, as if noise were a possibility of predicted meaning. This dynamic is a reversal of the traditional relationship between signal and noise, echo of poststructuralist criticism that saw in the text no longer a stable structure of meaning, but an infinite play of differences.

This signal/noise reversal actualizes Claude Shannon’s intuitions on information theory, where information is defined precisely by its capacity to surprise, to introduce the unexpected into a system. In this perspective, algorithmic “noise” – these textual productions that at first seem incoherent or inappropriate – can reveal signifying potentialities that our habitual attention did not perceive. This is exactly what Barthes called the “grain of the voice”: this particular texture that escapes constituted meaning and opens toward other interpretive possibilities.

Memory

Collaboration with AI constitutes the emergence of a new type of technical memory. Whereas Bernard Stiegler, following phenomenology, distinguished primary retentions (immediacy of perception), secondary (comparative temporalization) and tertiary (inscription on material support), we are witnessing today the emergence of quaternary retentions that concern attentional gestures and habits themselves.

This typology of retentions, inherited from Husserl but radicalized by Stiegler, takes on a new dimension with generative AI. Primary retentions concern what “just passed” in consciousness, this temporal fringe that allows perception to have thickness. Secondary retentions constitute conscious memory, the capacity to remember and compare. Tertiary retentions, specifically human according to Stiegler, are these technical “temporal objects” (writing, image, recorded sound) that allow preserving and transmitting experience beyond individual life.

Quaternary retentions operate according to an unprecedented logic that actualizes Barthes’s conception of reading as production. They no longer aim at identical recall of what has been, but feed on the past of tertiary retentions to “possibilize” them in latent space. They can both anticipate and regenerate them, creating what Barthes called “a nomination in becoming, a tireless approximation, a metonymic work.” This logic finds its technical translation in what is called “real-time inference”: at each interaction, AI instantly mobilizes billions of parameters to construct its response, creating a form of memory that does not store contents but relations between concepts. It is a memory without archives, that recomposes inedited configurations at each instant from abstract patterns.

Quaternary retentions transform our relationship to temporality by introducing a predictive dimension into technical memory. Where tertiary retentions preserved traces of the past, quaternary retentions generate virtualities of the future. They do not content themselves with archiving what has been; they calculate what could be, based on what has been. This predictive capacity of technical memory constitutes a major anthropological rupture: for the first time in human history, our memorial “prostheses” do not content themselves with preserving the past, they actively participate in the configuration of the future.

This pretentional dynamic structures our behaviors through an instantaneous back-and-forth between what is retained from the past and what projects us toward a pre-formed future. We have proposed with Yves Citton the term “distension” to designate this extension that, from tertiary retentions, multiplies the number of documents by creating a retention of retentions, an attention to attention, a memory of memory.

“Distension” precisely describes this unprecedented temporal modality where the present finds itself stretched between an algorithmically recombined past and a statistically anticipated future. We no longer live in a punctual present, but in a stretched temporality where each interaction with AI simultaneously actualizes traces of the past (learned patterns) and projections toward the future (possible completions). This temporal distension transforms our experience of duration and, consequently, our relationship to writing and reading. This temporal compression becomes vertiginous with recent models that generate entire novels in a few minutes. The asymmetry between production time (seconds) and reading time (hours) upsets the attentional economy: why invest an evening reading what was generated in one click? This question forces us to rethink the value of text: it no longer resides in production effort but in the pertinence of generation and, above all, in our capacity to project meaning into it, to inhabit it through our reading.

Writing with AI shows that technique is not a simple tool in human hands, but constitutes the transcendental condition of the emergence of humanity. In an epiphylogenetic logic dear to Stiegler, “what” invents “who” as much as it is invented by him. This constitutive exteriorization upsets our understanding of authoriality in a way that joins the intuitions of reception criticism: the reader truly becomes the producer of meaning.

Epiphylogenesis, this process by which human and technique co-evolve, finds in generative AI a particularly striking actualization. Our interactions with language models simultaneously modify our own cognitive patterns and the algorithm’s parameters. We learn to “prompt” effectively, developing new attentional competencies, while models adjust to our preferences via “reinforcement learning from human feedback” mechanisms. This co-adaptation demonstrates that we have entered a new phase of epiphylogenesis, where technical exteriorization concerns no longer only our gestures and memories, but our cognitive processes themselves.

AI functions according to a circular temporality where predictions retroactively shape the data that feed them. This temporality shows that perception and action emerge as two faces of the same computational coin, actualizing Barthes’s vision of a reading that “does not consist in stopping the chain of systems,” but “in engaging these systems according to their plurality.” This phenomenon intensifies with human feedback learning systems: our “thumbs up” and “thumbs down,” our reformulations and corrections are integrated into future versions of the algorithm. We thus become, without knowing it, co-trainers of the AI that completes us. Each conversation imperceptibly modifies the model, creating a temporal loop where the machine’s future is built with our present reactions.

This temporal circularity perhaps constitutes the most destabilizing aspect of generative AI. It introduces into our temporal experience a recursive dimension that recalls the paradoxes of self-fulfilling prophecy and hyperstition. Our present interactions with AI influence the data that will serve to train future versions of the algorithm, which in turn will influence our future interactions. We thus participate in the configuration of our own cognitive future, but according to modalities that largely escape our conscious control.

The Untenable

In the process of AI-assisted literary creation, the “reader” becomes the creative agent, fully realizing Barthes’s prophecy according to which “the goal of all literary work is to make the reader no longer a consumer, but a producer.” Faced with the textual flux generated by the algorithm, the human first adopts a reading posture: they discover, evaluate, select among the machinic propositions. This reading is not passive; it is already creative, already editorial.

This transformation of the reader into producer takes on an immediate practical dimension here. Barthes spoke of this transformation in theoretical terms, as the utopian horizon of literature. With generative models, this utopia becomes technical reality and thereby does not realize the original messianic promise: each user effectively becomes producer of the texts they read, since these texts exist only by and for their interaction with the algorithm.

Writing with AI does not correspond to the classic gesture of “writing,” but to that of editing. The operator of this retranscription occupies a hybrid position: reader as much as co-author, editor more than writer. This position actualizes Umberto Eco’s figure of the “model reader,” but in a context where this model reader literally becomes producer of the text they read. It is important to understand that this situation of editing-writing is no longer that described by Kenneth Goldsmith in his experiments of “uncreative writing” or by Nicolas Bourriaud in Post-production.

Goldsmith, in Uncreative Writing: Managing Language in the Digital Age, theorized a poetics of appropriation founded on what he called “language as material.” His approach consisted in treating words as undifferentiated building blocks: “Letters are undifferentiated building blocks – none having more or less meaning than another; vowels and consonants are reduced to decimal code.” His emblematic projects involved pure copying: completely retyping Kerouac’s On the Road (Simon Morris), recopying a complete edition of the New York Times in Day (Goldsmith himself), or his radio transcription experiments. This approach inscribed itself in what he called “managing language in the digital age”: faced with “the blizzard of language” of the Web, the writer became a “master typist,” “rigorous cutter-paster,” whose task was to “replicate, organize, reflect, archive and reprint.”

Goldsmith’s approach already expressed the mechanized dimension of writing in the digital age, but according to a still artisanal logic. His copying gestures, even when they aimed at exhaustivity and automaticity, remained tributary to a human intentionality that selects, frames, contextualizes. His “uncreative writing” was paradoxically very creative in its choices of constraints and materials. It was still an aesthetic of conscious appropriation, where the artist fully assumes their gestures of détournement.

Bourriaud, in Post-production, described an aesthetic of “remix” where artists “inhabit” culture like a landscape of given forms that they rearrange according to new combinatorial logics. This appropriation practice remained in the order of manipulation of preexisting elements, what Bourriaud conceptualized as a “post-production” that comes after production to reorganize it.

Bourriaud’s “post-production” still supposed a clear distinction between first production and second reappropriation. The artists he analyzed – from Félix Gonzalez-Torres to Philippe Parreno – worked from a constituted cultural patrimony that they reassembled according to new logics. This approach, although it questioned the notion of originality, preserved a linear temporality: first cultural production, then its artistic reorganization.

With generative AI, we leave the domain of technical reproducibility to enter that of vectorial automation of resemblance. The difference is fundamental: where Goldsmith manipulated existing texts in their digital materiality (“Digital text is the bodily double of print, the ghost in the machine”), AI generates texts that have never existed in this form. It is no longer a matter of “cutting, pasting, skimming, transferring, spamming,” but of generating resemblances without a unique model from latent vectorial space. This transformation rests on so-called “Transformer” architectures, which function by distributed attention: the algorithm does not read text linearly as we do, but simultaneously examines all words in a sentence to understand their mutual relations. This “panoptic” reading allows it to generate variations that preserve stylistic coherence while producing the unprecedented, creating texts that resemble without ever repeating exactly.

This “vectorial automation of resemblance” constitutes a qualitative leap compared to anterior practices. It no longer manipulates constituted cultural objects, but abstract patterns that can generate an infinity of variations. This generative capacity transforms our relationship to imitation: instead of imitating particular works, AI imitates the generative rules that underlie sets of works. It does not copy, it extrapolates; it does not reproduce, it resembles.

Goldsmith still conceived digital writing as management of the existing: “Words today are bubbles, metamorphs, empty signifiers, floating on the invisibility of the network, this great equalizer of language, from which we siphon avidly and without discrimination.” This metaphor of “siphoning” shows that his “uncreative writing” remained tributary to a Web conceived as a reservoir of preexisting texts to extract, recover, divert, recontextualize. Even his concept of “provisional language” — temporary, unstable, recombinable language — remained anchored in a logic of circulation and displacement of already constituted contents.

Goldsmith’s “provisional language” nevertheless anticipated certain aspects of generative aesthetics. His insistence on instability, recombination, circulation prefigured a relationship to text that privileges variation over fixation, process over product. But this intuition remained limited by its dependence on preexisting industrial contents. Generative AI liberates this logic of variation by making it productive: it no longer contents itself with recombining the existing, it generates the new from abstract patterns.

AI does not merely “siphon”: from massive cultural extractivism, it calculates probabilities of co-occurrence in latent space to generate unprecedented textual configurations. Where Goldsmith revealed the artificiality of writing through the monstration of its mechanical reproducibility, AI reveals the artificiality of writing through the demonstration of its stochastic generativity. The difference is not of degree, but of nature: we no longer manipulate preexisting linguistic “atoms” in a “collision space,” but we negotiate with an algorithmic alterity that permanently actualizes new textual possibilities from statistical patterns.

This difference transforms the position of the “reader-editor.” Goldsmith contented himself with selecting and framing preexisting materials according to “infallible processes” inspired by Sol LeWitt; the AI user must negotiate with a machine that generates unpredictable variations in real time. It is no longer a matter of “post-production” that comes after production, but of “co-production” where reading and writing intertwine in a temporally undecidable process. As Barthes observes in S/Z, “to describe is to place the empty frame that the realist author always carries with him […] before a collection or continuum of objects”: the AI user places this frame no longer before the Web as textual archive, but before the latent space of textual possibilities in perpetual actualization. This co-production intensifies with conversational interfaces: writing becomes dialogue. Each exchange modifies the context for the next response, creating a conversation memory that influences the entire session. AI “remembers” our preferences, adapts to our style, anticipates our expectations. This dynamic adaptation produces a form of troubling cognitive intimacy: the algorithm seems to learn who we are through our way of writing with it.