Anticipation et génération des réseaux récursifs de neurones

« Une intelligence qui, à un instant donné, connaîtrait toutes les forces dont la nature est animée et la situation respective des êtres qui la composent, si d’ailleurs elle était suffisamment vaste pour soumettre ces données à l’analyse, embrasserait dans la même formule les mouvements des plus grands corps de l’univers et ceux du plus léger atome ; rien ne serait incertain pour elle, et l’avenir, comme le passé, serait présent à ses yeux. »

Pierre Simon Laplace, Essai philosophique sur les probabilités

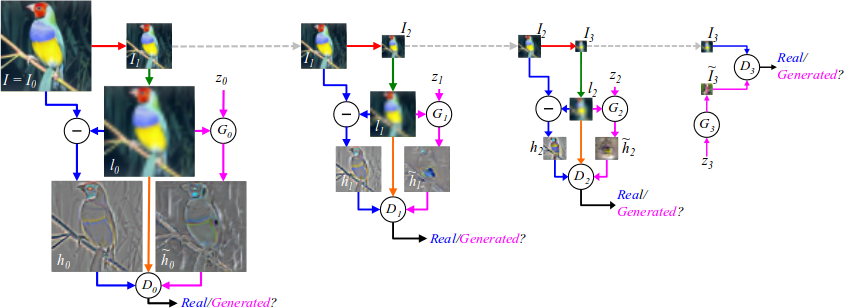

Le neural.net est laplacien parce qu’il prévoit en calculant la possibilité d’une récurrence (Nitish Srivastava, Elman Mansimov, Ruslan Salakhutdinov, 16 feb 2015). En ce sens, il apparaît contradictoire avec l’hyperchaos et la contingence. En se fondant sur des grands ensembles de données (les datasets) accumulés sur les réseaux sociaux, le RNN déduit ce qui va pouvoir être. Il vectorise pour se faire des documents qui en tant qu’inscription sont passés. Cette vectorisation permet d’éviter de manipuler des symboles sémantiques et se limite donc aux mathématiques. La contingence n’a pas lieu d’être avec le RNN parce qu’elle n’a jamais eu lieu. Elle n’est pas d’autres lois, elle est hors-la-loi, sans loi.

Toutefois si le RNN n’est en capacité que de prévoir la récurrence et le retour d’une mêmeté par exemple en décrivant exactement une image (l’adéquation entre l’image et sa description visuelle est alors déterminante), il est capable de produire des singularités. En effet, le RNN n’est pas seulement un logiciel permettant l’anticipation et la prévision, il peut aussi générer (https://github.com/samim23/facegen). En mêlant les données passées, il peut produire d’autres données ressemblantes et différentes tout à la fois. Cette ressemblance différentielle (permettant de reconnaître une parenté, mais dont l’exemplaire est unique) pose à nouveaux frais la question de la mimésis et de la représentation à l’heure de l’intelligence artificielle et du big data. La génération RNN n’est donc pas contingente, elle n’est pas sans loi, elle fait varier les variables jusqu’à la limite de la reconnaissance selon un schéma classique de Gestalt .

Il y a ainsi une ambivalence esthétique et structurelle du neural.net quant à sa conception implicite du monde : dans l’anticipation prévisionnelle il est du côté du même, du côté de la génération il est du côté de la différence parce que se rapprochant de la collection des données il n’est identique à aucune donnée particulière déjà existante.

Entre le RNN en tant qu’outil de contrôle anticipatif ou en tant que médium génératif et contingent, il y a peut être l’espace même entre l’anthropologique et le technologique.